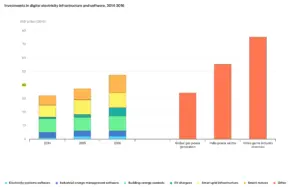

Mai come oggi il mondo dell’energia ha bisogno di Big Data. Gli investimenti mondiali in infrastrutture digitali sono cresciuti annualmente più del 20% dal 2014 al 2016, raggiungendo i 47 miliardi di dollari nell’ultimo anno preso in esame, secondo l’Agenzia internazionale dell’Energia (Iea). Non sono dati recentissimi, ma la tendenza è chiara, soprattutto se si pensa che quanto stanziato nel 2016 è stato quasi il 40% in più rispetto agli investimenti nella produzione di energia elettrica da gas in tutto il mondo (34 miliardi di dollari) e quasi pari all’investimento totale nel settore dell’elettricità in India (55 miliardi di dollari).

Sentiamo spesso parlare di transizione energetica, ossia del passaggio da fonti fossili a rinnovabili, ma oggi abbiamo ancora bisogno di petrolio e gas. Ricercarli in maniera più mirata e in modo da renderne l’impatto ambientale quanto più contenuto diventa prioritario. Ecco allora che data science e Ict diventano imprescindibili nelle strategie aziendali del mondo energy: un esempio è Eni, che ha investito sulle opportunità che la tecnologia è in grado di fornire, non solo per le attività oil & gas ma anche per supportare la propria attività di ricerca al servizio dello sviluppo delle fonti energetiche rinnovabili.

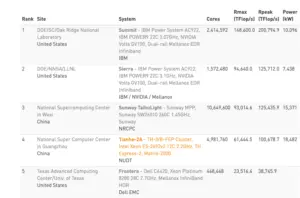

La multinazionale guidata da Claudio Descalzi non è certo l’unico caso. Se si considera l’ultima edizione della Top 500, ovvero la classifica mondiale dei supercomputer, il mondo dell’energia la fa da padrone. Al primo posto si trova quello di Ibm installato presso l’Oak Ridge National Laboratory, gestito dal Doe, il Dipartimento dell’energia degli Stati Uniti la cui competenza si rivolge alle priorità nazionali in materia energetica, oltre che di sicurezza e scoperta scientifica. E lo fa attraverso le capacità di calcolo del proprio supercomputer Ibm Summit da 200 Petaflops.

Lo stesso Dipartimento è presente, sempre attraverso centri scientifici, nella top ten: attraverso i laboratori nazionali Lawrence Livermore e Los Alamos: il primo equipaggiato Ibm, il secondo Cray (del gruppo Hpe – Hewlett Packard Enterprise). Nella top ten si piazza anche il National Institute of advanced industrial science and technology, ovvero una delle più importanti organizzazioni pubbliche di ricerca del Giappone. Un centro che tratta, tra le attività principali, proprio di energia, anzi più precisamente di fonti rinnovabili e soluzioni per l’accumulo e per l’efficientamento energetico. Il supercomputer installato è l’AI Bridging Cloud Infrastructure di Fujitsu.

Nelle prime venti posizioni, oltre a Eni, c’è un’altra azienda energetica: Total. È equipaggiata con tecnologia Ibm (Pangea III). Del gotha fa parte anche il Commissariat à l’énergie atomique et aux énergies alternatives, ente governativo anch’esso francese, ma con supercomputer Bull (brand di Atos). Nella classifica, oltre quelli citati, sono diversi i nomi di aziende Ict realizzatrici di supercomputer: da Dell Emc (al quinto posto con il suo Frontera, installato nel Texas Advanced Computing Center) a Lenovo (con cui è equipaggiato il centro italiano Cineca).

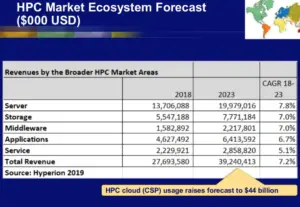

Del resto, i supercomputer sono uno strumento strategico ormai in molti settori: da qui si spiega come la tendenza a dotarsi di high performance computing sia in decisa crescita, tanto che lo scorso anno la società di consulenza Hyperion Research ha aumentato le proprie previsioni quinquennali relative al mercato Hpc fino a raggiungere i 44 miliardi di dollari nel 2023, rispetto alla precedente previsione di 39 miliardi di dollari (35 miliardi di euro) per quell’anno. Nel solo 2018 (ultimo anno di riferimento) il mercato dei server hpc è cresciuto di oltre il 15%, raggiungendo la cifra record di 13,7 miliardi di dollari in termini di fatturato. Riguardo al segmento dei supercomputer, i sistemi Hpc venduti per 500mila dollari o più, è cresciuto del 23% fino a 5,4 miliardi di dollari nel 2018, rappresentando il segmento in crescita del mercato dei sistemi di calcolo ad alte prestazioni.

Energia e Big Data: il lavoro di Eni per la ricerca oil & gas

Il gran data center di Ferrera Erbognone, in provincia di Pavia è il cuore tecnologico del gruppo Eni: conta 11mila sistemi sotto forma di server fisici e virtuali, 7000 collegamenti geografici a tutte le sedi mondiali, e serve anche per connettere il lavoro delle oltre 30mila persone attive nel gruppo. Costruito in collaborazione con Dell, triplica le performance del predecessore Hpc4 realizzato con Hpe: la potenza di calcolo passa da 18 a 52 PetaFlop/s, vale a dire 52 milioni di miliardi di operazioni matematiche svolte in un secondo, con una potenza di picco totale pari a 70 PetaFlop/s. L’architettura è stata concepita con la stessa filosofia delle precedenti, basate su tecnologia cluster ibrida (Cpu, Central Processing Unit + GPU, Graphics Processing Unit), un sistema accelerato inaugurato dal Cane a sei zampe già nel 2013 con applicazione nel settore industriale dell’Oil&Gas e oggi riconosciuta come vincente e ampiamente diffusa nei più importanti centri di calcolo mondiali. Tanta potenza è resa possibile dall’architettura in parallel computing: migliaia di server collegati fra loro che elaborano contemporaneamente milioni di miliardi di operazioni.

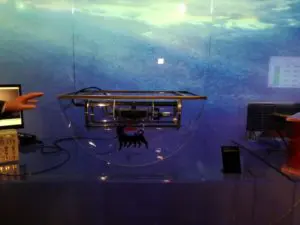

Uno dei focus è acquisire dati «che permettano di ottenere immagini del sottosuolo del tutto simili a radiografie», afferma Nicola Bienati, research geophysicist di Eni. È stato lui a descrivere, in occasione della visita al centro dati pavese, quali siano alcuni dei metodi utili per acquisire dati da prospezioni geologiche sottomarine (qui la videointervista con Industria Italiana). Uno di questi richiede l’impiego di apposite “navi-radar” in grado di scandagliare le profondità con speciali cavi provvisti di sensori che raccolgono gli echi dell’onda sonora che vaglia il fondale. Un altro, più avanzato e denominato Ocean Bottom Nodes, consente di avere sensori disposti direttamente sul fondale marino, mediante robot. «Con questo metodo di acquisizione riusciamo a ottenere dati più pregiati e di qualità migliore rispetto a quelli raccolti attraverso il modo convenzionale con i cavi trascinati dall’imbarcazione», afferma Bienati.

Dalla raccolta dati comincia il lavoro di ricostruzione veritiera del sottosuolo, rappresentativa delle strutture geologiche potenziali “trappole” di idrocarburi. In questo caso entrano in scena le tecnologie di imaging sismico, che trasformano i dati in immagini. «Le informazioni grezze captate non assomigliano per niente a quelle che un geologo si aspetterebbe di ottenere; sono proprio le tecnologie a creare una mappatura da dati grezzi a immagini interpretabili», precisa Bienati.

Gli algoritmi utilizzati per ottenere queste immagini si basano sul principio che le riflessioni registrate in superficie devono essere matematicamente riportate nei punti in profondità dove sono state riflesse verso l’alto. Questa operazione di rifocalizzazione dell’onda è alla base di tutti gli algoritmi di imaging sismico. Hpc5 permette ad Eni di studiare con straordinaria precisione i dati provenienti dal sottosuolo, consentendo di integrare e parallelizzare le fasi di esplorazione e di sviluppo. La combinazione tra Seismic Imaging e Hpc ha contribuito a tutte le più recenti scoperte esplorative di Eni nel mondo.

Il gruppo italiano ha fatto grossi investimenti non solo in supercomputer, ma nell’implementazione delle tecnologie di calcolo che permettono questa trasformazione, appoggiandosi sui calcolatori, sviluppati internamente e con la collaborazione con università italiane e straniere, tra cui la Stanford University, per approfondire lo studio delle geoscienze e del Seismic Imaging.

Energia e Big Data: Eni e i supercomputer per lo sviluppo delle rinnovabili

Come è noto, l’attività di Eni nell’energia non si limita agli idrocarburi. Nell’ultimo piano strategico, emergela determinazione far crescere il business dell’energia rinnovabile in modo organico: energia solare, eolica, da biomasse e non solo. Il mare diventa il punto di partenza per una fonte energetica rinnovabile perenne: onde, correnti, energia termica dal mare, oltre che eolico off shore sono tutti campi applicativi sviluppabili. Il moto ondoso è considerato la più grande fonte di energia rinnovabile inutilizzata del Pianeta: se si riuscisse a sfruttarla si otterrebbero 80mila miliardi di KWh (secondo i calcoli di Enea e Rse): cinque volte il fabbisogno annuale di energia elettrica del mondo intero.

Da qui ha preso avvio tre anni fa il progetto Iswec (Inertial sea wave energy converter), sviluppato insieme a uno spin off del Politecnico di Torino e che ha per oggetto uno scafo galleggiante sigillato con al suo interno una coppia di sistemi giroscopici collegati ad altrettanti generatori. Esso converte l’energia delle onde marine in energia elettrica, tramite un meccanismo che si attiva con l’oscillazione prodotta dal mare. Le capacità di calcolo offerte dai super computer hanno una parte importante per ottimizzare il funzionamento del sistema giroscopico alle condizioni locali del mare. Si tratta di analizzare e incrociare fra loro grandi quantità di dati da fonti diverse, quelli metereologici e quelli relativi al funzionamento della macchina. Grazie all’azione congiunta di Hpc4 e Hpc5 e alla loro potenza di calcolo è possibile contare su modelli matematici avanzati per elaborare formule di risposta adatte a ogni situazione. Questo è un altro esempio di raccolta di numerosi terabyte di dati.

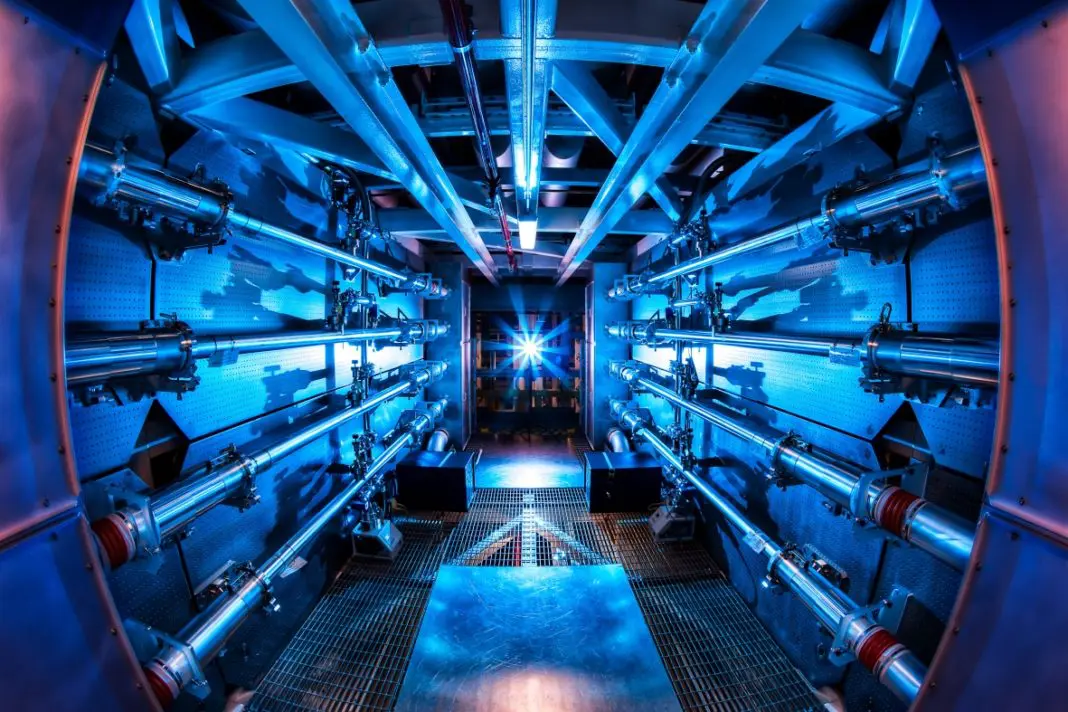

Energia e Big Data: il coinvolgimento di Eni nella fusione magnetica

Raccolta, analisi e utilizzo strategico di Big Data sono attività che ormai fanno parte integrante del core business di Eni, tanto quanto l’esplorazione petrolifera. È la fabbrica, non una sua funzione: lo si comprende anche da una delle attività di ricerca più avanzate qual è la produzione di energia da fusione a confinamento magnetico.

In estrema sintesi, è il metodo che intende replicare un processo simile alla fusione che avviene nel Sole. «L’idrogeno è l’elemento più abbondante nell’universo – spiega Claudio Carati, fisico e ricercatore senior Eni – i processi di fusione che avvengono all’interno delle stelle liberano elio e grandi quantità di energia. Lo stesso processo può essere riprodotto in laboratorio in condizioni controllate. Il green data center e i supercomputer ci sono necessari perché i modelli matematici e fisici sono utili a disegnare e costruire soluzioni per la fusione a confinamento magnetico e per il loro controllo – sottolinea Carati – Hanno bisogno di grandi capacità di calcolo, di modelli molto sofisticati. Non solo: siccome questi processi avvengono su una grande scala di tempo e di lunghezza è necessario contare su modelli che li possano esprimere adeguatamente e poi concatenarli l’uno all’altro per dare una descrizione completa delle macchine. La potenza di calcolo necessaria è davvero notevole: contare sul nostro data center è fondamentale».

Eni è impegnata su questo fronte e si avvale della collaborazione di Enea, Cnr, ma anche di enti di ricerca internazionali quali il Massachussets Institute of Technology di Boston, attraverso il Mit Laboratory For Innovations in Fusion Technologies. «Insieme a loro stiamo lavorando allo sviluppo di due macchine per la fusione: Sparc e Arc. Il primo (Smallest, possibile, affordable, robust and compact), sarà un reattore mediante cui, a livello sperimentale, verranno studiate tutte le condizioni necessarie per raggiungere le condizioni di fusione; Arc, invece, sarà il primo impianto dimostrativo che dovrà produrre energia da immettere sulla rete. Si parla di una produzione attesa nell’ordine dei 500 MW con un’emissione dieci volte inferiore (nell’ordine dei 50 MW). Una volta raggiunte le condizioni di fusioni stazionarie si potrà spegnere l’impianto che riscalda il plasma, che si autososterrà senza necessità di ulteriore impiego di energia», conclude il fisico Eni.