Ci parleranno, e noi converseremo con loro. Se avranno bisogno di utensili o di una qualche attività da parte dell’operatore compagno di cella (industriale), gliene faranno gentile richiesta. Se vedranno che quest’ultimo è stanco, e non regge il ritmo, si assumeranno l’onere di produrre di più, per raggiungere l’obiettivo. Comprenderanno il contesto. Interpreteranno le circostanze. I cobot, piccoli bracci sensorizzati destinati a interagire fisicamente con gli esseri umani in spazi di lavoro condiviso, già sono sul mercato. Con telecamere e sistemi anticollisione, coordinano la propria azione con quella degli operatori. Manipolano le cose. Ma una rivoluzione è in corso: fra pochi anni, saranno molto, ma molto, più intelligenti e determinanti in tempi di lotti ridotti e customizzati. Lo shopfloor non sarà più quello di prima.

Ci sono tre condizioni perché ciò accada. Anzitutto lo sviluppo della consapevolezza semantica da parte del cobot. Questo non deve solo capire che una cosa c’è, ma anche cos’è. Per questo, occorrono nuovi sensori e nuovi algoritmi di machine learning. Serve poi una divisione dei compiti tra uomo e cobot su base scientifica, realizzata da algoritmi di task assignment. Infine il cobot deve essere in grado di ripianificare la propria attività in base al contesto. Un po’ come il robot mobile cambia strada se incontra un ostacolo, il cobot deve essere capace di modificare la propria attività in rapporto alle circostanze. In ciò, l’intelligenza artificiale è fondamentale.

La quarta condizione è implicita: è la diffusione del 5G, lo standard che consente la trasmissione di una grande mole di dati in tempi ridotti. Infatti, per sviluppare un cobot intelligente è fondamentale l’accesso a grandi quantità di dati provenienti da vari punti della fabbrica e, quindi, è fondamentale un’infrastruttura di comunicazione come il 5G.

Quanto al linguaggio, sarà multimodale: vocale, gestuale e altro. Come fra le persone, ci si intenderà in più maniere. Tutto questo, secondo Cristian Secchi, docente al dipartimento di scienze e metodi dell’ingegneria dell’università di Modena e Reggio Emilia, nonché componente del gruppo roadmap che supporta il lavoro dello steeringcommittee di uno dei 7 Gruppi Tematico Tecnico-Scientifico (Gtts) del Cluster Nazionale Fabbrica Intelligente, il Gtts6 sui Sistemi di produzione evolutivi e resilienti.

L’associazione presieduta da Luca Manuelli riunisce aziende, regioni, università ed enti di ricerca con l’obiettivo di aggregare tutti gli attori più importanti a livello italiano sulle tematiche della manifattura avanzata. Tra le sue principali iniziative, la definizione della nuova Roadmap, documento strategico per indirizzare la trasformazione digitale dell’industria, che definisce le priorità di ricerca e innovazione sulle quali puntare nei prossimi anni come sistema Italia. Il presidente del comitato tecnico scientifico del Cluster è Tullio Tolio, docente di tecnologia e sistemi di lavorazione al Politecnico di Milano. Alla seconda Roadmap lavorano sette Gtts con il supporto del gruppo Roadmap del Cluster. Tra le tematiche sulle quali sta lavorando questo Gtts, che si occupa di sistemi di produzione evolutivi e adattativi, la definizione di percorsi innovativi per creare nuove sinergie nel rapporto uomo-robot. L’argomento è stato oggetto di approfondimento nel corso del WebMeeting “Sistemi di produzione evolutivi e resilienti”, animato dallo steering commitee del Gtts6 e tenuto qualche giorno fa. Hanno partecipato, oltre a Secchi e Manuelli, il Cluster Manager Cfi Paolo Vercesi, la ricercatrice del Cnr Rosanna Fornasiero in qualità di coordinatore del gruppo roadmap del Cluster, il manager SapIoT di Deloitte Maurizio Lilli, il docente di tecnologia meccanica e sistemi di lavorazione all’Università di Bologna Luca Tomesani, il direttore tecnico di Adige (Gruppo Blm) Paolo Benatti e il docente al dipartimento di ingegneria gestionale del Politecnico di Milano Marco Macchi. Si tratta di uno degli eventi previsti dal calendario di avvicinamento della seconda Roadmap: i comitati direttivi dei Gtts si confrontano con i partecipanti al gruppo, ne raccolgono e ne elaborano le idee per poter arrivare alla definizione delle priorità di ricerca e innovazione da proporre ai Ministeri per i prossimi anni. Abbiamo scelto di approfondire con questa intervista al prof. Secchi la priorità di ricerca e innovazione che propone nuovi percorsi per migliorare la relazione tra uomo e robot.

D: I cobot già sono sul mercato. Perché il co-working tra uomo è robot è considerata dal Gtts6 una priorità di ricerca e innovazione?

R: «Perché la nuova sinergia tra uomo e cobot stravolgerà del tutto, in modo radicale, il paradigma dell’introduzione e dell’uso della tecnologia in fabbrica. Un esempio, per capire, relativo alla programmazione di robot industriali ma anche della maggior parte dei cobot. Oggi l’operatore di processo comunica al programmatore che intende realizzare una certa operazione con la macchina. I due parlano lingue diverse. Si capiscono fino ad un certo punto. In qualche modo, il secondo è chiamato a tradurre in linguaggio informatico la richiesta del primo. Ecco, nella nostra visione la fabbrica intelligente non ha più bisogno del programmatore-intermediario. L’esperto del processo parla direttamente con la macchina ed è il dominus del suo campo. Il programmatore utilizza le sue competenze per operazioni a maggior valore aggiunto. Ma perché tutto ciò accada, vanno realizzate tre condizioni: consapevolezza del robot dell’ambiente circostante, suddivisione ottimizzata dei task all’interno della cella e capacità della macchina di ripianificare le sue attività in base alle contingenze».

D: Andiamo con ordine: di che genere di consapevolezza parliamo?

R: «Il punto è la consapevolezza semantica del cobot. Per ora, non c’è; ma non siamo tanto lontani. Attualmente un robot collaborativo riesce a percepire la posizione degli oggetti, avendo di loro una conoscenza geometrica e spaziale. Si tratta di fare in modo che la macchina apprenda anche il significato di una cosa, di un movimento umano o di altro. Dev’essere in grado di interpretare l’ambiente che la circonda, come fanno le persone. E di reagire in base ai mutamenti del contesto. Cosa manca per raggiungere questo traguardo? Già si parla di fusione sensoriale: invece di disporre di pochi sensori, il cobot disporrà di una quantità di fonti eterogenee di dati diversi, e riuscirà ad interpretare le informazioni grazie al machine learning. Sul punto, le basi ci sono, ma occorre tanta ricerca industriale, su nuovi sensori e algoritmi».

D: E quale sarebbe la giusta divisione del lavoro tra umano e cobot in cella? E chi la stabilisce?

R: «Inizialmente, si considerano i tempi nominali di realizzazione di una certa attività. L’operatore, ad esempio, impiega 10 minuti per maneggiare filo metallico duttile; mentre il Cobot fatica ad afferrarlo, per cui impiega tre volte tanto il tempo necessario all’umano. In altre attività, la macchina è velocissima, mentre l’uomo è impacciato. Questi tempi nominali vengono considerati da algoritmi di task assignment per suddividere al meglio il lavoro tra uomo e robot. Ma in concreto l’operatore può avere tempi diversi da quelli medi. E qui interviene il cobot, che si rende conto – in base a quel genere di consapevolezza di cui si parlava prima – di questa differenza di rendimento e interviene ripianificando il proprio task, in vista di una attività collaborativa ottimizzata».

D: Il cobot, cioè, è abbastanza intelligente da capire che l’umano sta “perdendo colpi” ed interviene ripianificando la propria attività? Come funziona?

R: «Come gli Agv, i robot mobili autonomi, sono in grado di modificare di continuo la traiettoria in base agli ostacoli e a esigenze contingenti di produzione, così il cobot deve essere in grado di comprendere il contesto e adeguare la propria condotta. Deve avere “sia le orecchie che gli occhi aperti”. Deve capire se l’operatore umano ha bisogno di questo o quell’utensile, di questa o quella attività. Deve interpretare miliardi di dati provenienti dal campo».

D: E dove dovrebbe essere allocata l’intelligenza per fare tutto questo? Nel cobot?

R: «A mio avviso, no. Si aprono due scenari: o l‘intelligenza artificiale distribuita negli asset e nei componenti dell’azienda – ma pare un obiettivo a lungo termine – o un server centralizzato che fa da supervisore a singoli “cervelli” prossimi alla macchina. In tutti i casi, non nella macchina. Nella nostra visione, la fabbrica è l’entità intelligente, lì dove tutte le tecnologie collaborano tra di loro».

D: In questo contesto, l’edgecomputing e il 5G sembrano assumere un ruolo cruciale

R: «Il 5G in particolare comporterà un salto tremendo nella robotica e nell’integrazione delle tecnologie in fabbrica. Mentre negli standard precedenti la quinta generazione il trasferimento dati avveniva tra una antenna, un server remoto a migliaia di km di distanza e il device in fabbrica, con il 5G il server viene sostituito da un apposito elaboratore a bordo rete. Di qui l’alta velocità, la bassa latenza, le enormi quantità di dati elaborabili. E questo consente l’innesto dell’intelligenza artificiale, che si nutre di masse considerevoli di informazioni. Sia per la fabbrica intelligente, che per la collaborazione tra uomo e cobot, l’infrastruttura è fondamentale».

D: Lei afferma che il cobot e l’operatore parleranno direttamente, senza l’intermediazione del programmatore. In che modo?

R: «Nella nostra visione, l’operatore e il cobot parleranno nel modo più adeguato in rapporto alle circostanze. Possiamo anche immaginare una comunicazione vocale: è una modalità diretta, gradevole, efficace. E le tecnologie per realizzarla esistono già. Ma alcune operazioni possono anche essere insegnate al cobot “prendendolo per mano”, e cioè spostando il suo braccio per fargli vedere come si compie una certa azione, come si realizza una certa traiettoria. Insomma, con il cobot si comunicherà esattamente come facciamo fra noi umani: secondo un modello “multimodale”. Alla fine, le persone sono molto brave a comprendere l’importanza delle cose in base al tono o al gesto. Naturalmente, noi combiniamo i canali di comunicazione e attribuiamo delle priorità. Tutto ciò non è immediato, ma non è neppure lontano nel tempo: l’orizzonte è quello del 2025, 2026».

D: Mi fa un esempio di ciò che accadrà con questo genere di comunicazione? Qualcosa che attualmente non accade

R: «Nella suddivisione del lavoro, se il cobot per operare avrà bisogno di una certa informazione o di una certa attività da parte dell’umano, non farà altro che chiederla. Il cobot è consapevole, capisce ciò che è utile e ciò che è conveniente».

D: Già esistono dei cobot facilmente programmabili

R: «È vero. Ci sono metodologie brevettate che consentono agli operatori senza esperienza di configurare e gestire rapidamente i cobot grazie a una visualizzazione 3D intuitiva. Si sposta il braccio del robot su punti di riferimento spaziale e si toccano tasti freccia sul tablet. Ma ciò riguarda solo la traiettoria, il movimento dal punto A al punto B. Invece, noi vogliamo insegnare al cobot a collaborare con l’operatore in ambito industriale, che è tutt’altra faccenda. Non solo deve imparare a muoversi, ma a saldare; e deve avere un “rapporto” tale con l’umano da accorgersi se è stanco, se il suo lavoro sta rallentando, e chiedere in queste occasioni all’umano se può intervenire per favorirne l’attività. Il lavoro dell’operatore è calato al 30%? Bene, il cobot chiederà di fare il restante 70%».

D: Insomma, come sarà questo cobot del futuro prossimo?

R: «Si pensi allo smartphone: è una macchina complessa, piena di brevetti, eppure tutti sono capaci di utilizzarla, a prescindere dalla cultura scientifica e dalle competenze in informatica. Ecco: il cobot deve diventare una tecnologia avanzata alla portata di chiunque. Come Alexa».

D: In che senso la nuova relazione tra cobot e umano migliorerà la qualità del lavoro di quest’ultimo?

R: «Ad esempio, esistono degli indicatori che definiscono la correttezza della postura di un operatore. Si chiamano Reba (rapid entire body assessment; ndr) e Rula (rapid upper-limb assessment; ndr) e valutano il sovraccarico biomeccanico attribuendo un certo punteggio a singole operazioni. Ora, si può fare in modo che all’interno della cella il cobot porga all’umano un componente o un utensile in modo da non rendere necessari sforzi statici o dinamici da parte di quest’ultimo, tutelandone la salute. Si può programmare il cobot in modo che si rifiuti di collaborare ad operazioni che determinano un quarto movimento di un certo tipo, quando secondo gli indici citati una persona può compierne solo tre nel corso di una giornata. Forse, così non si va nella direzione dell’efficienza a breve termine; ma si prende la strada della qualità dell’attività lavorativa, che non è meno importante».

D: Quali ostacoli alla diffusione di questa tecnologia? Come siamo messi in Italia?

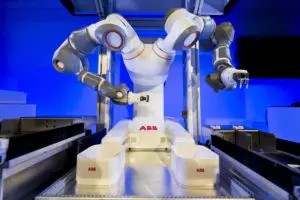

«L’ostacolo più grande, per ora, è che si è creduto di poter utilizzare i cobot come dei robot industriali privi di schermo, intrinsecamente più sicuri perché muniti di sistemi anticollisione. Così, però, risultano solo dei robot più lenti e inefficienti di quelli chiusi in una gabbia. Tutto il vantaggio, invece, sta nella collaborazione, nel fatto che le attività relative ad un certo task possono essere spartite tra uomo e macchina. Ma la collaborazione non è ottimale, se i livelli comunicativi tra uomo e macchina sono quelli attuali. C’è bisogno che si parlino veramente, e quello che proponiamo nella priorità di ricerca e innovazione va in questa direzione. Il Gtts6 e in generale il Cluster propone un percorso in cui le aziende si possono riconoscere e far proprio in ottica di sviluppare progetti innovativi sulla base dei propri obiettivi di sviluppo. Molte aziende stanno lavorando allo sviluppo di cobot sempre più efficienti. Ad esempio, Abb ha sviluppato Yumi per operazione collaborative bimanuali agili. Dotato di telecamere e di “mani” sensibili, Yumi è utilizzato, per esempio, per il controllo della qualità: verifica che il prodotto sia realizzato secondo le specifiche del cliente. È progettato per lavorare insieme alle persone e risponde a requisiti stringenti di sicurezza: dispone di algoritmi che lavorano in tempo reale per evitare “collisioni”. Se il robot incontra un oggetto inatteso, nel contesto della sua attività, si mette in pausa in alcuni millesimi di secondo; il movimento può essere riavviato facilmente, premendo play su un telecomando. Ogni braccio si flette su sette assi, imitando così i movimenti umani con grande efficienza spaziale. La nostra Università, poi, collabora con una Start-up molto avanzata, “Industria Tecnologica Italiana” che lavora tantissimo nel territorio per integrare la robotica collaborativa nelle aziende locali. Penso che i cobot assumeranno un rilievo molto più grande nello shopfloor di domani. C’è bisogno di flessibilità, di adattabilità. I grandi lotti sono finiti e avanza la customizzazione di massa. Di robot che fanno 100mila pezzi al giorno forse ne serviranno sempre di meno».

Il cluster, la Roadmap e il Gtts6

Il Cluster Nazionale Fabbrica Intelligente è una associazione che dal 2012 riunisce aziende, regioni, università ed enti di ricerca con l’obiettivo di creare una comunità manifatturiera avanzata, stabile e competitiva. Tra le sue principali iniziative, la definizione della Roadmap, documento strategico per indirizzare la trasformazione digitale dell’industria italiana, individuando le principali necessità della manifattura italiana in termini di avanzamento tecnologico. Il documento ha sia lo scopo di indirizzare le attività di ricerca e innovazione delle aziende manifatturiere, sia proporre agli organi istituzionali quali i Ministeri dei percorsi di approfondimento lungo i quali puntare con politiche industriali mirate. Attualmente, sette gruppi tematici tecnico-scientifici (Gtts) formati da esperti, docenti universitari e soci del cluster sono impegnati nella redazione della seconda Roadmap. Nel documento vengono individuati macro-scenari di sviluppo, le cosiddette linee di intervento. È stata definita una matrice, che consente alle aziende di posizionarsi lungo queste direttrici in base al proprio percorso di innovazione.

L’attività dei Gtts è coordinata dagli steering committee, comitati direttivi che raccolgono ed elaborano i contributi dei soci. Quello del Gtts6 è composto da Paolo Benatti (Blm Group), Gildo Bosi (Sacmi Imola), Edmondo Gilioli (Cnr-Imem), Fabio Golinelli (Abb), Marco Macchi (Politecnico di Milano), Luca Tomesani (Università di Bologna), Sandro Salmoiraghi (Salmoiraghi), e dal roadmapping support member Cristian Secchi. La linea di intervento è motivata dal fatto che – in un mondo che procede a velocità diverse e in un mercato sempre più variegato ed esigente – la fabbrica deve sapersi adattare in modo veloce e resiliente. Servono macchine e strumenti di analisi sempre più potenti, e metodologie per integrare in modo ottimale le nuove tecnologie. Il gruppo ha quindi individuato le seguenti priorità di ricerca e innovazione, definendo per ognuna di esse quali sono gli obiettivi sui quali lavorare nei prossimi anni. Le priorità sono: la progettazione e controllo di sistemi di produzione riconfigurabili; la realizzazione di componenti, sensori e macchine intelligenti per la produzione adattativa ed evolutiva; i sistemi per la predizione delle prestazioni e la gestione operativa della produzione e della logística; la Smart Inspection e il Machine Learning; e infine le nuove sinergie nella collaborazione uomo-robot, argomento che rappresenta il fulcro della presente intervista. Peraltro, sul tema si è di recente tenuto un web meeting, organizzato dal Cluster Fabbrica Intelligente, dove sono state presentate e discusse le priorità con i soci del cluster e altri esperti interessati a conoscere da vicino la realtà del cluster e dando occasione di validare le scelte dello steering committee sul mercato produttivo.