I sistemi storage utilizzati all’interno dei data center hanno conosciuto negli ultimi anni una rapida evoluzione. Non stiamo parlando dell’aumento della capacità dei dischi rigidi, e nemmeno del grande incremento della potenza elaborativa raggiunta grazie ai dischi a stato solido Ssd, che stanno rapidamente sostituendo i dischi rotativi in un numero sempre maggiore di casi.

L’evoluzione più significativa è quella che ha riguardato l’organizzazione stessa dello storage nei data center. I sistemi monolitici di vecchia concezione sono in difficoltà a gestire nuovi carichi di lavoro che derivano dai nuovi trend quali: intelligenza artificiale (AI), Big Data analytics, Internet of Things a questo si aggiunge la modalità architetturale Hybrid Cloud fra infrastrutture on-premise dei clienti e Public Cloud a rendere la sfida ancora piu complessa.

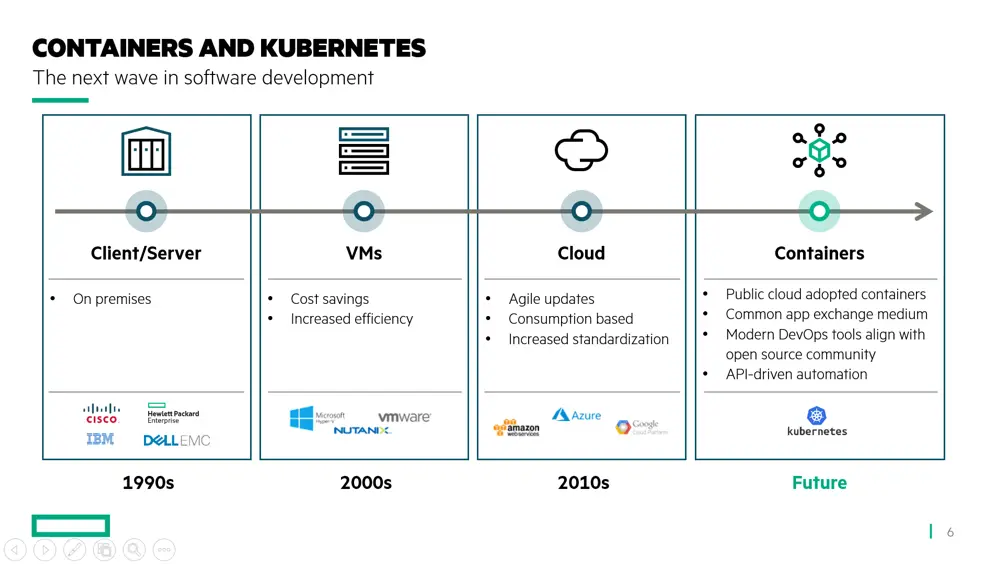

Questo cambiamento è richiesto delle nuove esigenze applicative che i Ced devono soddisfare. La composizione e la complessità dei workload che girano oggi in un centro di calcolo sono rapidamente aumentate rispetto a quella che tipicamente si aveva solo 10 anni fa. Oggi le applicazioni tradizionali (Erp, Database…) sono affiancate da altri trend quali: Container, data analytics , Cloud ibrido, Kubernetes, virtualizzazione Vdi, per non parlare delle applicazioni collegate in qualche modo al mondo manifatturiero e alle operazioni IoT, che con Industria 4.0 cominciano a produrre dati da trattare nel Ced: intelligenza artificiale e machine learning usate per analizzare enormi quantità di dati provenienti dall’IoT, sistemi di gestione della manutenzione predittiva, governo della supply chain. Queste nuove applicazioni richiedono flessibilità, latenze minime, alto throughput, accesso random istantaneo, disponibilità del dato 24/7 senza tempi morti per eventuali backup/restore e con tempi di fermo programmato per manutenzione ridotti all’osso. Difficile rispondere a queste esigenze con le vecchie tecnologie storage, ottimizzate essenzialmente per i sistemi gestionali, i database relazionali e gli Erp, carichi con andamenti ben prevedibili.

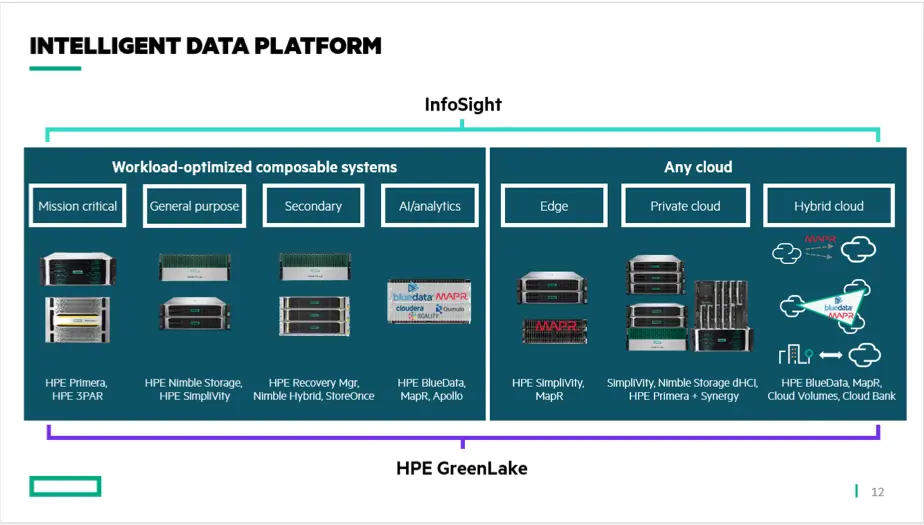

La conseguenza di tutto questo è che la gestione delle risorse del Ced, impegnate a rispondere alle esigenze contrastanti di workload convenzionali e innovativi, e distribuite fra on premise e cloud, si è fatta estremamente complessa. Tanto che l’imperativo, oggi, non è solo di assicurare efficienza all’infrastruttura, ma soprattutto di semplificarne il dimensionamento, la gestione, l’upgrade e il “fine vita”, il tutto garantendo in ogni momento la sicurezza dei dati. A queste esigenze Hpe risponde con una serie di prodotti hardware e software inquadrati nella Intelligent Data Strategy.

Adattare i Ced ai nuovi workload

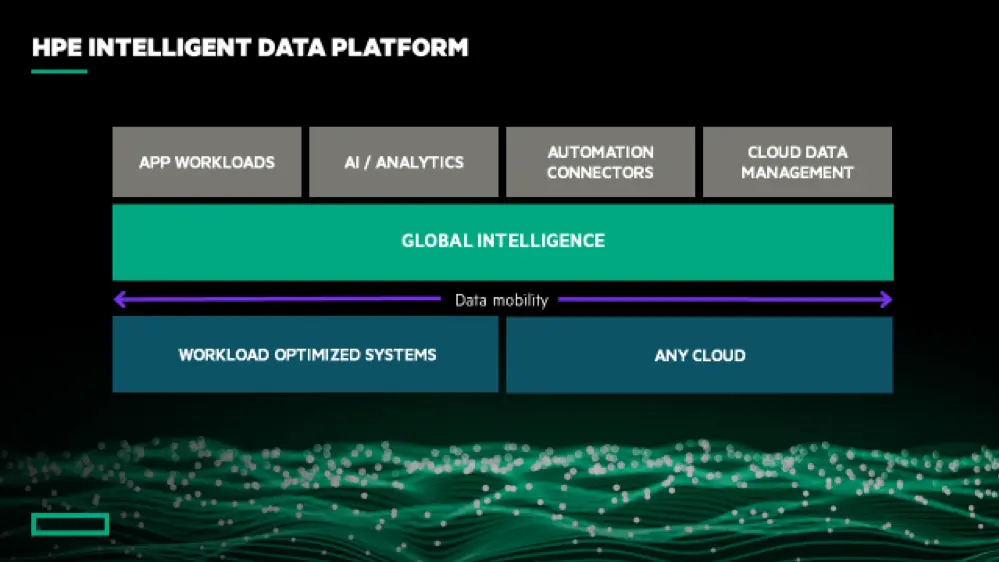

«Partendo dal dato di fatto che l’adozione dell’Hybrid cloud, ovvero l’affiancamento del cloud pubblico alle infrastrutture on premise dei clienti sta crescendo e che questo permette di semplificare al cliente l’uso della piattaforma It – conferma Dario Schianchi di Hpe Italia – Quello però che noi vediamo ogni giorno è la sfida che i clienti si trovano a gestire con la diversità dei workload, e quindi di tipologie di carico, in questo momento. La risposta di Hpe sul lato storage, indirizza sia le tipologie di workload tradizionali, sia tipologie molto diverse, che vengono per esempio dall’intelligenza artificiale, dai big data, dal trattare una serie di dati per avere vantaggi di business, di mercato, per avere nuovi prodotti o per capire cosa vogliono i consumatori. Quindi il paradigma per noi è la capacita’di adattarsi ai workload che stanno arrivando. Definiamo questo modello architetturale “Intelligent Data Strategy”. In esso il dato prende un posto sempre più importante, visto che siamo sempre più in presenza di tipologie di dati che arrivano da contesti sempre diversi e che devono essere correlati fra di loro».

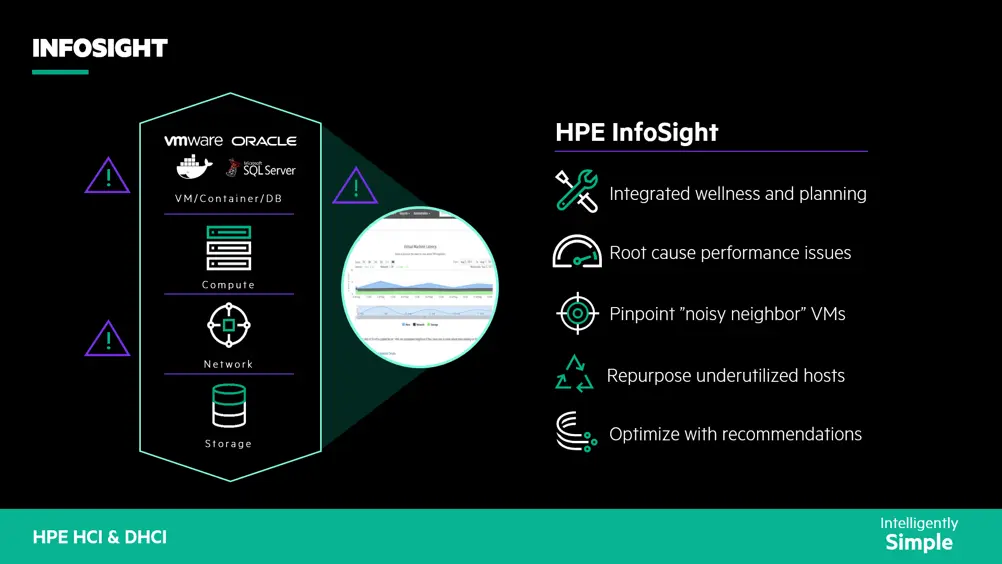

La Ids si appoggia sui servizi a consumo GreenLake e consulenziali, che sono fra i punti forti di Hpe, sull’Intelligent Data Platform e sulle capacità dell’Advanced Analytics, ovvero le nuove forme di metodologie analitiche che permettono di correlare tipologie di dati ed estrarre informazioni utili che possono essere date al marketing o ai buyer. Il cuore pulsante di questa strategia dell’Ids è InfoSight, che non è un prodotto ma è uno strumento di supporto proattivo basato su portale Web, acquisito da Hpe con l’acquisizione di Nimble nel 2017. Esso permette a tutti i clienti Hpe, di ottenere una serie di informazioni personalizzate sui loro ambienti e di avere accesso in tempo reale a raccomandazioni specifiche per migliorare continuamente l’utilizzo delle risorse.

Questo approccio permette di accorciare i tempi di tuning e di soluzione di problemi complessi da individuare, da una visibilità end-to-end dell’infrastruttura partendo dagli ambienti virtuali (Vmware e Hyper-V) passando dai server fino ad arrivare allo storage Hpe. «Per la parte di Intelligent Data Platform Hpe copre tutta la gamma di offerta necessaria per le diverse tipologie di workload sia a livello Server che a livello Storage e in particolare è molto forte sui primary storage, parliamo di Nimble, di Primera che è l’ultimo uscito nella famiglia. Sono prodotti storage che abbinano alla capacità di gestire workload tradizionali come Oracle, Sap, Sql, anche il loro utilizzo su nuovi tipi di workload, come container, Splunk, MongoDb, quindi tipologie che sono entrate in modo sempre più spinto nei centri di calcolo dei nostri clienti».

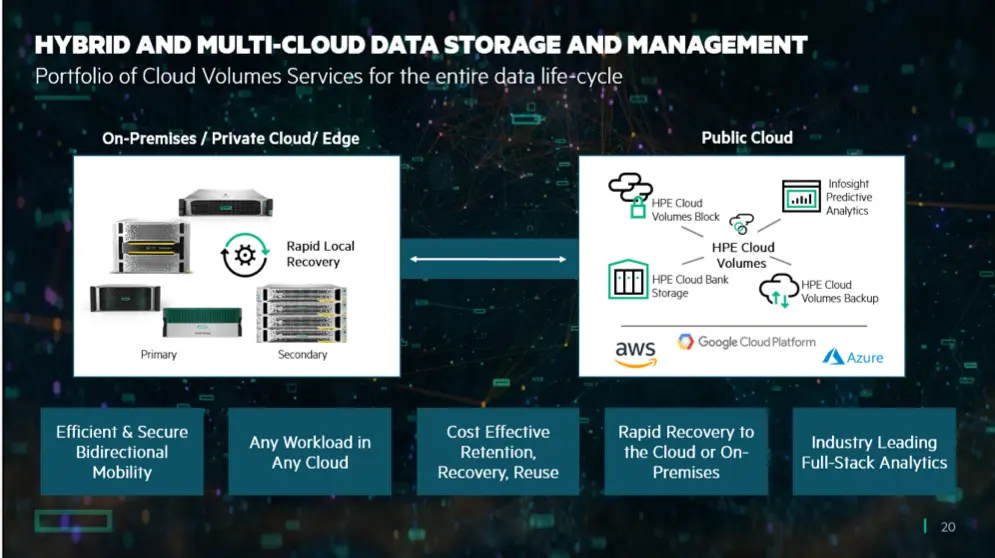

L’Idp deve essere flessibile, avere la capacità di fornire una data mobility per abbinarsi all’hybrid cloud, e tutto questo viene coordinato e verificato dal punto di vista di InfoSight. I clienti Hpe tipicamente si trovano a gestire una situazione in cui ci sono workload ben conosciuti, come Oracle, per il quale hanno le risorse e gli skill, ma anche workload come Splunk o MongoDB, che sono tipologie completamente innovative. E su questi nuovi workload il cliente non ha esperienza, quindi ha bisogno di qualcosa che lo aiuti rapidamente a gestire in modo efficiente la sua infrastruttura storage, la quale anche al variare dell’utilizzo deve rimanere performante. Questo viene garantito da InfoSight. Esso dà delle “recommendation” in tempo reale, che sono diverse dalle “best practices”: InfoSight ti dirà che in base alla tua situazione, al tuo ambiente operativo, alle tue applicazioni, è meglio se fai questa cosa o quest’altra. Dal portale il cliente vedrà sia il comportamento della sua infrastruttura, sia le recommendation con i miglioramenti che si possono ottenere applicandole.

«Nimble (storage disponibile all flash o ibrido flash/rotativo) è stato il precursore dello sviluppo di Infosight e della Predictive Data analitics a cui sono seguiti Hpe 3PAR e Primera ( storage mission critical equipaggiato con dischi flash). Sono primary storage, molto performanti, scalabili, che fanno della semplicita’ e flessibilita’ il proprio punto di forza. Nimble in particolare riduce drasticamente le attivita’ di gestione, è adatto a ambienti Smb in cui sono richiesti costi competitivi ma prestazioni paritetiche a storage di fascia superiore. Hpe Primera, ultimo nato nella famiglia storage Hpe, è uno storage All Flash che è in grado di erogare performance molto elevate e garantire ai clienti l’affidabilità e la scalabilita tipiche di ambienti Mission Critical. Entrambi gli storage possono scalare sia in modalità verticale (aumentando la capacità) che in modalità orizzontale (aumentando la potenza elaborativa) e si avvalgono di un programma di refresh nel tempo che permette di avere sempre risorse di calcolo di ultima generazione. Il programma Hpe Timeless ha lo scopo di semplificare il refresh tecnologico storage nel tempo senza dover affrontare migrazioni, fermi e impatti sui clienti finali. Ci sono poi prodotti che si adattano alle novità, prodotti tipo BlueData (piattaforma software di classe enterprise basata sui container) e MapR (un data fabric per Kubernetes e big data), che costituiscono le fondamenta della Container Platform Hpe e si interfacciano alle modalità analitiche di Ia e big data. E non stiamo parlando della parte Hpc (high performance computing), in cui Hpe è un leader di mercato dopo l’acquisizione di Cray nel Maggio 2019. Le modalità Hpc sono sempre piu presenti nei data center tradizionali e danno una grande vantaggio tecnologico a Hpe» conclude Schianchi.

Analizzare i dati storici con l’intelligenza artificiale

«Oltre ai componenti di Ia, l’altro vantaggio enorme che abbiamo con Nimble è che ha 10 anni di telemetria dei dati di storage storicizzati – afferma Claudio Bassoli, Vp di Hpe – Perché il punto non è solo guardare quello che avviene sulla macchina, ma anche fare il confronto con le serie storiche. Quindi predire cosa succederà non solo in base a quello che vedo da quel singolo cliente, ma in base alle serie storiche di tutte le macchine di quel tipo, 10 anni su Nimble, 4/5 anni su altre architetture. Quindi abbiamo la possibilità di fare manutenzione predittiva non solo in funzione di quello che sta avvenendo nel sistema del singolo cliente, ma anche paragonandolo a tutte le serie storiche». Poter contare su un database di telemetria così esteso ha un grande valore, perché da un lato permette di capire in anticipo e prevenire eventuali fault, e dall’altro consente di dimensionare efficacemente i sistemi.

«Succede molto spesso quando ci troviamo a fare progetti in ambito big data, per quanto i clienti siano bravi a fare il sizing dell’infrastruttura storage, che non si riesca a percepire quanti dati verranno generati dagli utenti finali, perché queste soluzioni vengono guidate dal business e quindi è difficile predire quanti utenti interagiranno con le applicazioni. Si fanno ipotesi basandosi sull’esperienza passata, ma ovviamente la modalità di interazione su questi nuovi workload genera una mole di dati tale che il più delle volte il cliente magari fa una pianificazione per tre anni e in 6 mesi brucia tutte le risorse. Avere a bordo questa intelligenza artificiale gli permette di capire cosa avverrà andando avanti così fra uno, due, tre mesi, e gli evita di scoprirlo pochi giorni prima di raggiungere una situazione critica, cosa che può comportare problemi».

Tutto questo dunque consente di avere una governance in tempo reale, sia a livello di predictive maintenance sia di provisioning. Se poi consideriamo il fatto che un’azienda spesso non lancia una sola nuova soluzione ma tante, cosa che rende ancora più arduo prevedere gli andamenti dei carichi, avere questo automatismo basato su Ia acquista ulteriore valore per il cliente, perché fa la differenza fra avere successo o meno nella customer experience. L’alternativa è ricorrere pesantemente all’overprovisioning di risorse, una soluzione che può avere vari aspetti negativi, a partire dai costi.

GreenLake riduce i costi iniziali

«Tipicamente i clienti acquistano il 100% in più di capacità, perché ipotizzano un aumento del 20% ogni anno per 5 anni – spiega Mauro Colombo, Sales Manager di Hpe – Ma non c’è peggior modo di utilizzare il proprio budget It, che in questo momento in alcuni casi è in riduzione, o è uguale ma allocato su basi diverse. Comprare fin dall’inizio il doppio dello spazio necessario non è una buona idea. GreenLake in questo aiuta, perché viene consegnata l’infrastruttura che serve al momento zero, più un buffer del 20 o 30% che il cliente paga solo quando lo consuma. E man mano che questo buffer si svuota, come un serbatoio, c’è un sistema di monitoraggio remoto che ci dirà se dobbiamo portare storage aggiuntivo al cliente perché lo sta consumando in modo più rapido del previsto. Quindi l’accoppiata delle tecnologie che abbiamo con GreenLake è l’ideale per il mercato italiano in questa situazione contingente».

«Non solo GreenLake dà una risposta come in questo caso ai clienti in crescita anno su anno, ma esistono situazioni dove i clienti usano l’overcapacity sui picchi – aggiunge Bassoli – Un esempio per la parte computing sono le assicurazioni, che solo due volte l’anno hanno bisogno di sviluppare la gestione del rischio e hanno bisogno di molto calcolo. Quindi usano la capacità soltanto per un mese, in cui fanno una serie di simulazioni. In quel periodo la loro spesa di infrastruttura si posiziona sul punto di picco, poi non useranno più il sistema al massimo per gli altri 11 mesi. GreenLake è una risposta a questo bisogno: non pagherai tutta l’infrastruttura, ma avrai una rata flat e pagherai soltanto la variabilità di quel mese nel quale vai a utilizzare quel 20, 30% in più di buffer che ti serve. Questo è un altro esempio di come abbiamo risolto un problema ai nostri clienti. Altri picchi sono l’e-commerce sotto Natale, la grande distribuzione che aumenta la spesa online durante i saldi, il black friday. Non c’è più solo il batch di Sap a fine mese, stiamo vedendo tantissimi momenti di picco nelle aziende».

La riduzione dell’overprovisioning è un vantaggio per il business ma anche per l’ambiente, perché consente di ottimizzare le risorse. Hpe è impegnata sull’ecosostenibilità dei prodotti, e un modello a consumo consente alle aziende di promuovere sia un uso più efficace dei materiali, sia la riduzione del consumo di energia. Inoltre, in ottica di economia circolare la formula as a service permette all’azienda di smaltire i propri asset arrivati a fine vita in maniera sicura e conforme ai parametri di ecosostenibilità, aiutando perciò le aziende a realizzare gli obiettivi di sostenibilità ambientale che, soprattutto in questo momento storico, sono sotto la lente e richiamano molta attenzione.

Gestire con InfoSight ogni tipo di storage

Tornando alla problematica iniziale, abbiamo visto che InfoSight aiuta a semplificare lo storage Hpe, ma cosa succede se il sistema informativo comprende anche altre tipologie di storage? «L’iperconvergenza è una delle modalità con cui si possono affrontare alcune tipologie di esigenze – premette Schianchi – Alla base di tutto c’è la necessità di semplificare la gestione di questi ambienti. C’è una complessità nell’It che si sta cercando di semplificare tramite l’automazione e l’iperconvergenza. Per noi InfoSight è “cross”, quindi serve sia l’iperconvergenza, sia la disaggregated iperconvergence, (storage separato dai server ma gestito come quello integrato, NdR) ed è molto utile nel caso di ambienti virtualizzati (VmWare e Hyper-V). Tramite InfoSight, il nostro cliente che compra storage è in grado di avere una visione completa dall’ambiente virtualizzato (cross stack analytics ) che partendo dall’utilizzo delle risorse dei server (memoria, Cpu) arriva fino al dettaglio di utilizzo del nostro storage, una visione che gli permette di semplificare tutti i processi di provisioning e tuning. Tramite il nostro storage è possibile avere i dati di un ambiente che può essere multivendor, perché si mettono insieme i dati su come si stanno comportando per esempio VmWare e le virtual machine, sull’uso della memoria della Cpu e sulle risorse che ha VmWare. Se mette questi dati in relazione con quello che sta facendo lo storage, il cliente è in grado da solo di capire dove potenzialmente c’è un collo di bottiglia. E possiamo fare lo stesso con i nostri iperconvergenti della famiglia Hpe SimpliVity».

L’iperconvergenza arriva storicamente dal Robo (Remote Office Branch Office), da tutto ciò che era remoto e man mano sta entrando nei data center. Hpe con SimpliVity è fra i player importanti sull’iperconvergenza, che di fatto è un modo per semplificare l’infrastruttura IT di un cliente, sia nelle fasi iniziali d’installazione che nell’operativatà e nella gestione quotidiana. SimpliVity risponde benissimo all’esigenza perché permette di “federare”. Ci sono aziende che hanno uffici in tutto il mondo o in tutta Italia, e tramite la federation dei SimpliVity possono avere un unico punto di accesso, di visione e di gestione per tutti i loro siti remoti. Inoltre Simplivity è il sistema Iperconvergente conosciuto per la capacità di protezione del dato in tutto il suo ciclo di vita: questo rende disponibile nativamente la funzionalità di business continuity a livello di Sito e di Disaster Recovery a livello Geografico senza l’esigenza di componenti Sw aggiuntive per indirizzarre queste funzionalità.

L’evoluzione dell’Iperconvergente Hpe Simplivity ha portato alla creazione di una ampia famiglia di prodotti full flash o hybrid, su piattaforme Intel o Amd, con compressione e deduplica inline sempre attiva in modilità Hw accelerated (scheda Hw dedicata) oppure in modalità completamente SW sfruttando le funzionalità dei processori di ultima generazione. E dal punto di vista SW l’evoluzione continua del prodotto sta portando Simplivity ad un percorso che possiamo definire dal Sito Remoto, verso il Datacenter Centrale e da qui verso il Cloud seguendo i paradigmi dell’evoluzione delle infrastrutture IT. Gli accordi con Google Anthos nel mondo Cloud ed il recente annuncio con Ctera aprono la strada a Simplivity verso l’approccio Hybrid Cloud da un lato e verso una soluzione Nas in locale con capacità di condivisione e sharing di file su Cloud dall’altro. E questi sono solo alcuni passaggi secondo un piano di sviluppo che procede con una regolare cadenza di rilasci.

Tuttavia l’introduzione dell’iperconvergenza nei data center dei grossi clienti, non sempre risolve tutti i problemi. È vero che semplifica la gestione, le operation, ma spesso mostra rigidità sulla gestione delle performance e sul mantenimento della linearità di latenza. Hpe ha affrontato questi aspetti con una duplice strategia: il primo passo è costituito dall’evoluzione della soluzione Iperconvergente Simplivity che diventa la prima Intelligent Hci attraverso l’integrazione con il Portale Cloud di Intelligenza Artificiale Hpe Infosight. Il secondo passo si basa sulla capacità di analizzare correttamente le caratteristiche del Workload che dobbiamo andare ad indirizzare e renderlo operativo attraverso la soluzione più efficace: Hpe, partendo dall’esperienza positiva di Simplivity ed integrandola con le soluzioni Intelligent Storage Hpe Nimble di ultima generazione, ha rilasciato sul mercato la nuova famiglia di soluzione Iperconvergente disaggregata denominata Dhci. «Ci siamo accorti (ed è confermato da analisti come Idc) che la Dhci (Disaggregated Hyper Converged Infrastructure) mantiene gli aspetti di semplificazione operativa e gestionale, ma con una flessibilità che l’iperconvergenza non possiede».

L’iperconvergenza non è la panacea

In pratica, l’infrastruttura Hci è composta da server modulari, con capacità di calcolo e storage integrate. Le opzioni di upgrade sono generalmente limitate, perché in queste architetture si preferisce aggiungere nuovi moduli standard piuttosto che modificare quelli installati. Da questo punto di vista Simplivity si differenzia per la sua capacità di supportare compute node esterni al sistema Hci per permettere una scalabilità solo computazionale quando il requisito si presenta.

Ma il problema dei clienti è proprio l’evoluzione nel tempo: partono con una configurazione e la situazione cambia, crescono i dati e serve più storage, oppure al contrario serve più potenza di calcolo e meno spazio di storage – come capita con gli analitycs. Che io abbia bisogno di spazio o di calcolo, con l’Hci devo acquisire ulteriori nodi di iperconvergenza completi (architetture scale out) che mi fanno sprecare l’una o l’altra risorsa, e anche soldi dato che in base al numero di nodi si pagano licenze per gli Hypervisor e i sistemi operativi. La Dhci invece mantiene il punto unico di gestione, ma fa in modo che le risorse di computing e storage possano crescere in modo diversificato. Lo storage può appartenere all’iperconvergenza, ma può anche gestire workload al di fuori dell’architettura Hci. «La Dhci, che facciamo con Nimble, è un concetto innovativo studiato per i medio grandi clienti, viste le esperienze che sono state fatte con loro su Hci. L’iperconvergenza è spesso spinta dai provider che vogliono qualcosa di semplice da gestire. SimpliVity e Dhci rientrano in quello che dicevamo prima, la capacità di vedere a colpo d’occhio dove c’è un miglioramento o dove ci sia un problema, che può essere latente. Se lo paragoniamo a una struttura classica di operation, a fronte di un problema da affrontare prima si mettevano in campo almeno tre risorse, necessarie lato storage, lato server e hypervisor. È questo che si sta cercando di semplificare. Il Dhci tra l’altro può essere applicato su ambienti ex-novo (greenfield) oppure in ambienti “brownfield”, dove ci siano già presenti server Hpe Dl360, DL380,DL560 quadrisocket, e si integra all’offerta di Cloud Volume Hpe basata su Cloud Volume Block e Cloud Volume Backup, offrendo una data mobility flessibile a seconda delle esigenze dei clienti».

Garantire la business continuity

Abbiamo parlato finora soprattutto di semplificazione della gestione e di mantenimento dell’efficienza, ma c’è un ultimo aspetto sul quale non si può transigere, ed è garantire la sicurezza dei dati. La business continuity e il disaster recovery sono pilastri fondamentali di una architettura It sicura e affidabile. Replicare il dato e poterlo utilizzare velocemente sono alla base della continuità operativa e di conseguenza garantiscono che le Business Unit di un’azienda possano continuare a essere operative anche a fronte di situazioni più o meno gravi. Ma come vengono gestiti dalla piattaforma storage Hpe gli aspetti legati alla security? «L’offerta Hpe Storage include metodologie di replica del dato e di modalità di gestione in business continuity e/o in Dr, come per esempio la Peer Persistence/Remote Copy degli ambienti 3Par/Primera /Nimble, la Data Virtualization Platform nativa di Simplivity o le data replication policy di MapR in ambiente software defined architecture.

Si combinano alle logiche di replica storage Hpe anche l’utilizzo di snapshot dei dati orientate al mantenimento di copie aggiornate, recenti e veloci da ripristinare e/o da utilizzare per scopi di testing e data verification. A integrare i piani di business continuity o data recovery di un cliente ci devono essere anche le politiche e metodologie di backup, che allargano la data recoverability nel tempo per evitare per esempio il ransomware. Hpe offre sui prodotti Primary storage una componente gratuita chiamata Rmc, in grado di creare snapshot dei dati da spostare in modo efficiente e intelligente verso le soluzioni di backup Hpe, come Storeonce e Vsa Software. La sicurezza e affidabilità all’interno di un data center poi non possono prescindere da sistemi di Role based access avanzati, e integrati nelle metodologie di accesso agli storage in tutte le sue varie forme di utilizzo e gestione (Gui, Command Line Api Rest…). Hpe investe su questo aspetto molte risorse dei laboratori, per avere sempre la garanzia di mantenere il livello di sicurezza necessario a proteggere le informazioni e gli accessi».