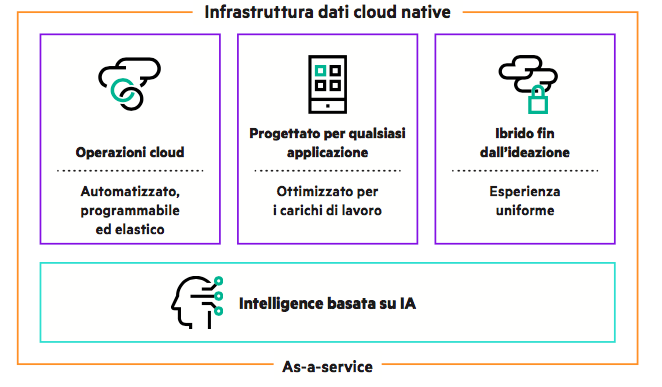

I dati hanno preso il centro della scena, e i clienti chiedono ai fornitori di tecnologie strumenti (che siano hardware, software o servizi) che permettano loro di trattarli in modo facile, integrato, rapido e con costi certi. Il cambio di paradigma ha innescato una serie di cambiamenti nell’organizzazione dell’It aziendale, prima con l’aumento dell’adozione del cloud, parallelo al calo di importanza dei sistemi on prem; poi con l’arrivo di formule come il cloud ibrido, capaci di unificare i servizi cloud e quelli on prem con un’interfaccia comune di tipo cloud; e più recentemente con piattaforme ancora più avanzate, come l’edge to cloud proposto da Hpe, dove il sistema di gestione delle risorse basato sul paradigma del cloud consente di “smaterializzare” in un certo senso sia l’hardware che i dati, che possono vivere ed essere gestiti e usati nello stesso modo indipendentemente da dove si trovino fisicamente e da come sono connessi o memorizzati. Le varie componenti che sono andate a creare le piattaforme GreenLake (per l’acquisizione As a Service dell’infrastruttura) ed Ezmeral (per creare una piattaforma software unificata basata su Kubernetes) sono stati i primi passi in questa direzione, passi completati ora da un ultimo componente che rappresenta però la chiave del successo di tutta l’architettura: la piattaforma di gestione dei dati.

Con questo ultimo tassello, si realizza la visione di Hpe di un data center che non è più un luogo fisico, ma che viene visto dagli uomini It come uno spazio virtuale, esteso appunto dall’edge al cloud. Perché ogni risorsa viene aggiunta, gestita e manutenuta in modo indipendentemente dalla sua posizione, e lo stesso si può dire dei carichi di lavoro e dei dati: non conta più dove sia situata un’applicazione, o dove risiedano i relativi dati, su un edge server o nel cloud di un hyperscaler. Inoltre, il day by day della gestione viene demandato in gran parte alla componente software della piattaforma, chiamata Data Services Cloud Control, che sfrutta gli algoritmi della piattaforma di Ia/Ml InfoSight per ridurre il carico di lavoro degli uomini It, gestendo in autonomia vari aspetti prima complessi (come il provisioning), e offrendo suggerimenti e analisi predittive per migliorare l’utilizzo delle risorse. La nuova piattaforma di gestione dati si appoggia a un hardware progettato appositamente in modo cloud-native, hardware che dà il suo nome a tutta la piattaforma: Alletra. Disponibile in due serie, ciascuna con diversi modelli, l’hardware Alletra è stato pensato per essere “invisibile” al cliente: è gestibile completamente in remoto, ovunque si trovi, e il software di controllo dotato di Ia si occupa di ogni aspetto di riconfigurazione e aggiornamento. Inoltre è totalmente ridondato e i modelli della serie 9000 offrono il 100% di affidabilità con il normale contratto di assistenza. L’argomento è stato affrontato da Tom Black, Senior vice president e General Manager Storage in Hpe, in un suo intervento al Discover 2021.

Il cambio di prospettiva: verso un data center cloud

Hpe sta andando oltre il concetto di hybrid cloud, tanto che ha aderito fin dall’inizio al progetto europeo Gaia-X, una sorta di “cloud federato aperto”, all’interno del quale ogni cliente può muovere liberamente i suoi dati e le sue applicazioni senza problemi di compatibilità. Come è apparso chiaro durante il recente evento Discover 2021, tutte le più recenti iniziative di Hpe vanno in questa direzione: semplificazione del lavoro di gestione dell’infrastruttura per il cliente; ortogonalizzazione che permetta di spostare ogni workload e ogni data collection fra strutture cloud e on-premise e di elaborare i dati dovunque si trovino, secondo la vision “dall’edge al cloud”; estensione delle formule “as a Service” o pay per use a tutti gli elementi in gioco – dai server allo storage, passando per il supercalcolo.

Si va, insomma, verso una nuova organizzazione di Data Center e di Sistema Informativo, sempre più virtualizzati. Il Data Center non sarà più un singolo luogo fisico che raggruppa tutta l’infrastruttura informatica, perché l’hardware di calcolo dell’azienda potrebbe in parte risiedere on prem, in parte essere posizionato da un provider di colocation, in parte potrebbe essere affittato da un cloud provider, anche solo on demand in caso di picchi di lavoro. Ma potrebbero esserci dei server anche all’edge, per esempio presso uno stabilimento, ai quali demandare la prima elaborazione dei dati IIoT provenienti dalle linee di produzione. Un esempio estremo, mostrato durante Discover 2021, è il nuovo Spaceborne Computer-2 di Hpe, dotato di coprocessori per Ia, che la Nasa ha spedito nello spazio per raddoppiare la capacità di calcolo (e moltiplicare quella sui compiti Ia) della Stazione Spaziale Internazionale. L’Sbc-2 è composto da un Edgeline Converged Edge e da un server ProLiant, e come l’Sbc-1 che lo ha preceduto qualche anno fa, è l’edge computer con il posizionamento più particolare, in orbita bassa sopra la terra e a una distanza continuamente variabile dal suo data center, visto che compie un’orbita ogni 90 minuti e in ogni momento può trovarsi in un punto qualsiasi sopra la Terra. Ora, tutte queste risorse di calcolo possono essere gestite – grazie a console che sfruttano il paradigma del cloud – come se si trovassero in un solo luogo, e addirittura in modo largamente indipendente dalle loro caratteristiche “fisiche”: sarà sempre lo strato software a farsi carico di tradurre le richieste dell’utente in comandi comprensibili all’hardware, ma anche in operazioni effettuabili dai software applicativi, visto che anche questi non sfuggono alla regola e possono venire gestiti in modo unificato, spostati da un server all’altro, eccetera, con ovvi vantaggi.

In tutto questo, rimane l’esigenza di memorizzare, elaborare e proteggere i dati a livello fisico, e questo si ottiene solo appoggiandosi ad hardware adeguati. Perché se è vero che è possibile “virtualizzare” qualsiasi risorsa di calcolo in modalità cloud, e semplicemente sostituirla in caso di problemi – di fatto, la potenza di calcolo diventa sempre più una commodity – è anche vero che la cosa davvero fondamentale è non perdere i dati, vero patrimonio aziendale. Non perderli fisicamente, a causa di guasti, o “logicamente” per bug software, manovre errate o attacchi hacker. Forse anche per questa estrema criticità il processo di astrazione della componente storage ha richiesto più tempo di altre nel paradigma del nuovo data center. Ma ora ci siamo.

Perché ha senso vedere lo storage come un servizio

«Stiamo trasformando tutto “as a Service” con Hpe GreenLake, la nostra piattaforma edge-to-cloud – ha detto Tom Black, durante il suo intervento – è il modo in cui noi forniamo servizi e un’esperienza cloud agile per le vostre applicazioni e dati. Il mese scorso abbiamo annunciato che stavamo espandendo GreenLake, trasformando Hpe Storage in un servizio cloud-native per i dati di tipo software defined. Abbiamo costruito la nostra Data Services Cloud Console basandoci sulla piattaforma Aruba Edge Service, che è utilizzata da anni da oltre 100.000 clienti e gestisce oggi 1,2 miliardi di eventi ogni ora. Inoltre, il Compute Team guidato da Neil MacDonald ha collaborato con noi con la sua soluzione di servizi cloud, la Compute Cloud Console».

Con questi aggiornamenti, GreenLake va incontro alle richieste di flessibilità e agilità dei clienti, e fondamentalmente estende le modalità operative e l’esperienza del cloud ai sistemi on-prem, o in ambienti di colocation, anche per quanto riguarda la gestione dello storage. Hpe definisce questa nuova visione “Unified Data Ops”. «Abbiamo svelato recentemente la nostra vision di Unified Data Ops, che crea una nuova esperienza nei dati, in grado di eliminare la complessità nell’intero ambito delle organizzazioni, e accelera la trasformazione data-driven per i nostri clienti. Stiamo già concretizzando questa vision con l’introduzione della Data Services Cloud Console, e della nuova infrastruttura di storage nativo cloud Alletra. Ulteriori servizi, soluzioni e prodotti miglioreranno ancora di più l’esperienza del cliente nei prossimi 18 mesi. Sappiamo che trasformare per sempre lo storage e la gestione dati è un obiettivo ambizioso, ma è esattamente quello che stiamo facendo, stiamo cambiando tutto. Dal modo in cui il cliente gestisce il suo storage oggi, a come andiamo sul mercato, fino al nostro portfolio di prodotti e soluzioni che i clienti ci richiedono e che ci consentono di offrire loro un’ottima esperienza in fase di supporto».

Ma cosa davvero cercano i clienti quando si tratta di definire lo storage per i dati aziendali? «Nel mio ruolo – spiega Black – parlo con centinaia di loro, e tutti vogliono accelerare la loro trasformazione digitale sfruttando il potenziale dei dati, ma la memorizzazione e gestione dei dati presenta un elevato livello di complessità, e rappresenta un grosso ostacolo. Una sfida da superare. Gli ambienti storage attuali si basano su una rete frammentata di infrastrutture e processi, limitazioni amministrative costellano tutto il ciclo di vita dei dati. Tutto questo va a scapito dell’innovazione, dell’agilità, e in tutta onestà crea anche un rischio per il business. Uno degli aspetti che il cloud pubblico ha saputo cogliere è stato il modello operativo, che ha definito uno standard per la semplicità e l’agilità per i clienti. Nel classico modello on-prem, se si voleva aggiungere un’applicazione o un workload, bisognava preparare un ordine di lavoro che richiedeva un coordinamento fra diversi team It, e questo processo a volte richiedeva giorni se non settimane, a seconda dell’azienda o della complessità. Pensiamo a cosa succede quando si hanno più processi, con più team coinvolti, in continuazione. L’ideale sarebbe invece poter disporre dell’esperienza operativa del cloud in entrambi i mondi, con la semplicità e la disponibilità on demand, as a service. In questo modo portiamo l’esperienza cloud ai nostri clienti, lì dove i dati risiedono».

La piattaforma data service Alletra

Poche settimane fa, Hpe ha annunciato Alletra, una nuova piattaforma di servizi dedicata ai dati. Essa è composta in particolare da due elementi. Il primo è la Data Service Cloud Console, una console SaaS che fornisce operazioni unificate sui dati attraverso una suite di servizi. Il secondo è l’hardware Hpe Alletra, un’infrastruttura per i dati cloud nativa studiata appositamente per l’impiego edge-to-cloud. Inquadrati in GreenLake, questi componenti portano ai clienti Hpe un’esperienza cloud unificata dall’edge al cloud, dal data center on prem a quello in colocation, gettando le basi per passare dalla gestione dell’infrastruttura storage alla gestione dei dati.

La riduzione della complessità di gestione dei sistemi storage è ottenuta sulla piattaforma Alletra sfruttando l’intelligenza artificiale e il machine learning, e in particolare il sistema Hpe InfoSight. Esso può fornire un modello predittivo sia per il supporto che per la gestione, in grado di prevedere e soprattutto prevenire i problemi. Il sistema di Ia inoltre fornisce raccomandazioni che migliorano la pianificazione, la disponibilità, l’utilizzo e le prestazioni delle risorse di storage. La componente hardware, il cui progetto deriva in parte dalle unità Primera, opera in stretta integrazione con la Data Services Console, per cui tutti i carichi di lavoro, che siano on prem o in cloud, vengono visti e operati come carichi cloud, con ovvi benefici in fatto di semplificazione della gestione. Alletra ottiene risparmi significativi in fatto di tempo impiegato per operazioni come distribuzione, provisioning, gestione e scalabilità dello storage. Operazioni come il provisioning vengono addirittura automatizzate completamente, gli aggiornamenti software sono trasparenti all’utilizzatore, e grazie a GreenLake si arriva a risparmiare un 40% di risorse It, secondo uno studio condotto da Forrester Consulting.

L’hardware di Alletra

Stefano Venturi, Presidente e Ad di Hpe Italia, ha puntualizzato recentemente che l’impegno di essere completamente as a Service entro il 2022 significa che l’intero portfolio di Hpe sarà disponibile as a Service, ma non che sarà disponibile solo as a Service. L’infrastruttura hardware su cui si basa la piattaforma Alletra è oggi disponibile in due diverse serie, la Serie 6000 e la Serie 9000. Entrambi i sistemi occupano 4 unità rack per ciascun nodo, ma la serie 6000 può alloggiare un massimo di 24 unità SSD di tipo NVMe, contro le 48 unità installabili nei modelli 9000. Il che si traduce in una capacità massima installabile di 368 Tb per la Serie 6000, che sfrutta un sistema Triple+ Parity per un’affidabilità del 99,9999%, e di 656 TiB (raw)/2.000 TiB (effettivi) per la Serie 9000, che utilizza uno schema Raid 6 (10+2) e vanta una specifica di disponibilità del 100%. Per garantire l’affidabilità totale, le macchine della Serie 9000 hanno fra l’altro moduli di alimentazione e raffreddamento ridondati con batteria e ventole, e almeno due controller ridondati che possono diventare quattro. Le interfacce host disponibili includono Fibre Channel 32 Gb/s e 16 Gb/s, oltre a Ethernet 25 Gb, 10 Gb e 10 GbaseT. Il modello top, siglato 9080, dispone inoltre di un controller più sofisticato rispetto al modello base (9060), con il triplo di memoria cache (3.072 Gb). A livello di prestazioni, la Serie 9000 supera i 2 milioni di Iops ed è caratterizzata da una latenza ridottissima, grazie ai dischi a stato solido Ssd: il 75% degli I/O è gestito entro i 250 microsecondi.

La Data Services Cloud Console

«Con la Data Services Cloud Console stiamo cambiando l’esperienza di storage in un modello interamente cloud. La Console è un SaaS pensato per fornire l’agilità operativa del cloud ed è progettato per unificare le operazioni sui dati, attraverso una suite di Cloud Data Services. Con questo sistema abbiamo separato i dati e i controlli dell’infrastruttura dall’hardware fisico, e forniamo un approccio completo e unificato alla gestione dei dati e della relativa infrastruttura, indipendentemente da dove si trova» ha spiegato Omer Asad, Vp General Manager per Primary Storage e Data Management Services di Hpe. Dalla console un cliente può gestire tutto il ciclo di vita dell’infrastruttura dati. E per il fatto di essere una suite di servizi basati su cloud, ogni volta che alla consolle viene aggiunto un nuovo servizio esso diventa immediatamente disponibile per tutti i clienti, in modo trasparente e senza causare interruzioni o richiedere aggiornamenti locali che, spesso, creano problemi di compatibilità con altri software di sistema.

I risultati ottenibili

Che tipo di risultati ci si può aspettare di ottenere adottando tecnologie come GreenLake e Alletra nel proprio percorso di trasformazione digitale? E soprattutto, che ruolo vuole ricoprire Hpe? «L’esperienza di Hpe consente a ciascun membro di un’organizzazione di risparmiare tempo – dichiara Black – e di semplificare notevolmente le operazioni. La nostra nuova soluzione storage consente all’It di risparmiare fino al 99% del tempo. È una statistica che abbiamo fatto, cronometro alla mano, su dei tipici workflow dei nostri clienti, misurati prima e dopo l’adozione della Cloud Console. E consente alle linee di business di fare provisioning di dati on demand, in una modalità self service. Aiutiamo gli amministratori It a gestire i dati in maniera più semplice. Siamo impegnati a essere un partner strategico per tutti i nostri clienti, per aiutarli ad accelerare la loro trasformazione digitale».