Universal Robots controlla, da sola, circa la metà del mercato mondiale dei cobot, una nicchia in forte crescita all’interno del comparto della robotica industriale. Avere una leadership così netta ha come conseguenza diretta la presenza di un vasto e articolato ecosistema fatto di accessori hardware, di software prodotti da terze parti, e di integratori. I prodotti compatibili vengono testati e certificati dall’azienda, che li pubblicizza su un apposito sito.

Per quanto riguarda la visione robotica, Universal Robot non fornisce sulle sue macchine un sistema premontato, preferendo che il cliente scelga la soluzione migliore per la sua applicazione. Abbiamo quindi fatto qualche domanda agli esperti dell’azienda per capire come viene gestita la scelta, l’integrazione e l’utilizzo di un sistema di visione sui suoi robot.

I vantaggi della robotica collaborativa

Se è vero che nel settore della robotica la parte del leone, come fatturati e numero di macchine, la fanno i classici grandi robot industriali, è anche vero che il segmento che registra la maggiore crescita anno su anno è quello dei cobot, o robot collaborativi; il Cagr 2015-2019 è stato del 67% contro il 13% dei robot convenzionali. I cobot sono macchine generalmente piccole, con costi iniziali molto bassi e facili da gestire, perfette quindi anche per aziende di piccole dimensioni. Hanno anche dalla loro una notevole versatilità, nel senso che sono rapidamente spostabili e riprogrammabili per eseguire nuovi task, e grazie alla presenza di sensori e software ad hoc possono anche collaborare fianco a fianco con gli operatori (di qui il nome di “collaborative robot”, abbreviato in CoBot), cosa preclusa ai loro fratelli maggiori, che operano all’interno di aree delimitate e devono fermarsi nel caso si avvicini un umano.

Se la recente pandemia ha provocato una contrazione generale dei mercati, la stessa pandemia potrebbe in un prossimo futuro dare un ulteriore impulso alle vendite dei Cobot, perché moltissime Pmi che producono beni considerati “non essenziali” si sono rese conto che, in caso di nuovi lockdown, l’unico modo certo per tenere in funzione un impianto è di poter lavorare con la minor quantità di personale possibile, in modo da poter rispettare i regolamenti sul distanziamento e le misure di sicurezza annesse. E i cobot possono dare risposta alle esigenze di molte piccole aziende che devono distanziare gli operai senza magari stravolgere il layout della linea – anche perché ciò è spesso fisicamente impossibile. Questo vuol dire anche dover affidare ai cobot compiti diversi e più complessi di quelli tipicamente svolti da queste macchine. Usarli per alimentare macchine utensili con pezzi contenuti alla rinfusa in cesti o scatole per esempio, o per eseguire il controllo di qualità su manufatti complessi o su pezzi che passano sparsi su un nastro trasportatore. E ancora, leggere codici a barre, fare pick&sort e via discorrendo.

Ma per svolgere questi compiti, il cobot va dotato di un senso che – nativamente – non ha: quello della vista. La machine vision, o visione artificiale, è probabilmente il segmento dove si giocherà realmente la partita per i cobot che dovranno prendere il posto degli umani. E se fino a poco tempo fa c’erano ostacoli oggettivi (dai costi altissimi dei sensori Lidar alla scarsa capacità di calcolo dei “cervelli” che dovevano elaborare le informazioni visuali), ora con i prezzi dei sensori in discesa e con gli sviluppi dell’IA e del machine learning i problemi più grossi sembrano risolti. I cobot quindi potranno accelerare sensibilmente quel processo di sostituzione del lavoro umano a basso valore aggiunto che era già iniziato a causa delle proiezioni demografiche, le quali indicano concordemente che nei prossimi 5/7 anni diventerà difficile, in tutti i Paesi occidentali, reperire manodopera da impiegare nelle fabbriche.

Dare la vista ai cobot

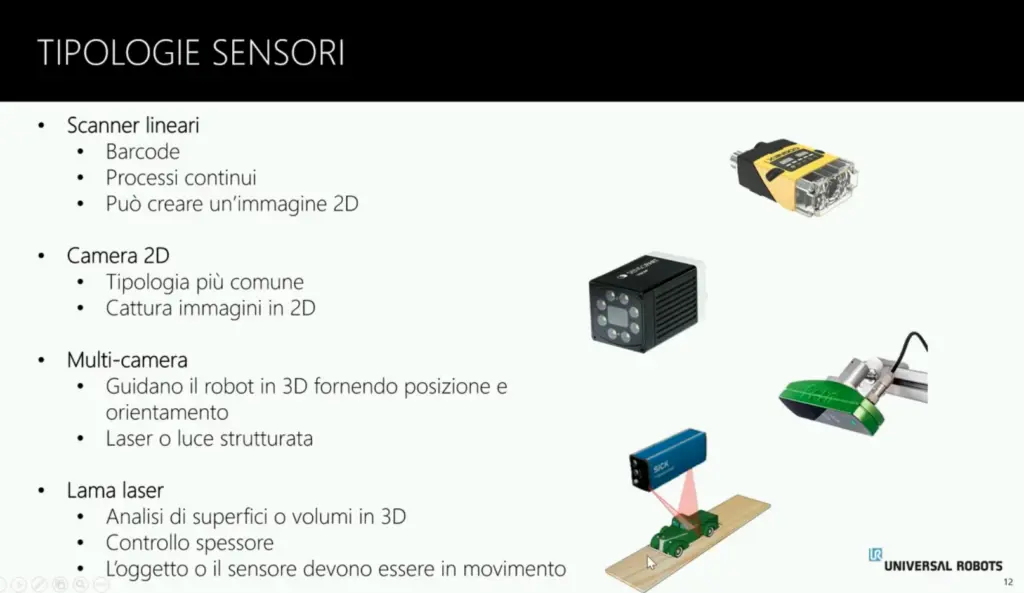

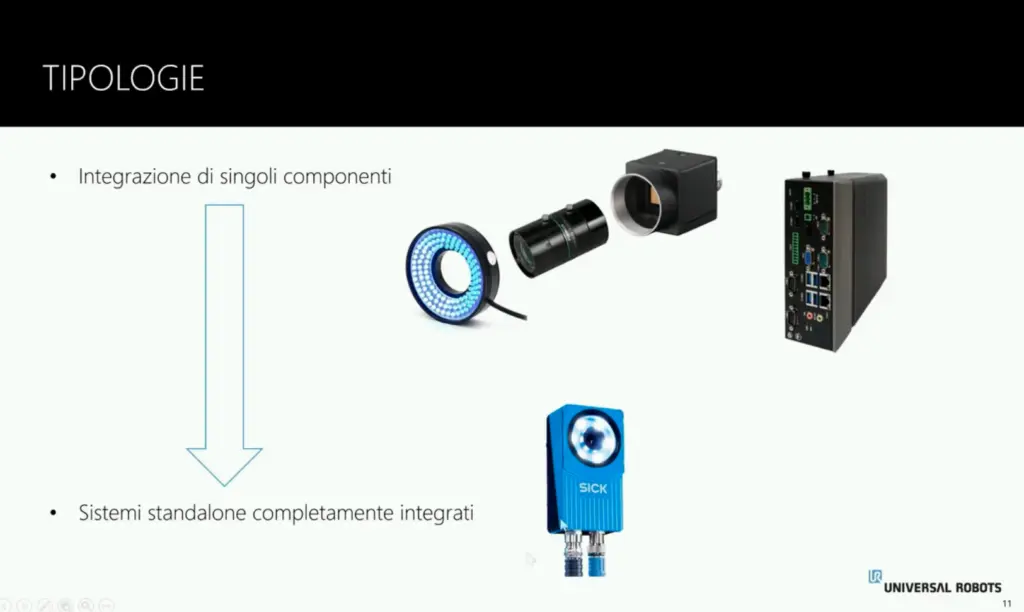

Per dotare un cobot del senso della vista, bisogna equipaggiarlo con un “occhio” elettronico, un apparecchio di cui esistono decine di tipologie, ciascuna delle quali pensata per specifici utilizzi. Si va da dispositivi molto simili nella struttura a una fotocamera digitale consumer, ad altri che lavorano come una videocamera, fino ad apparecchi capaci di “vedere” in 3D grazie a sensori Lidar o Tof, o all’estremo opposto apparati in grado di leggere non un piano ma solo una sottile riga, usati per rilevare i codici a barre. Se il cuore della maggior parte dei dispositivi è rappresentato da un sensore Cmos non molto diverso da quelli montati sulle fotocamere o sui telefonini, altre componenti del dispositivo assumono importanza critica nel caso della machine vision. Prima di tutto il sistema di illuminazione, che deve essere in grado di fornire la migliore resa luminosa possibile, senza ombre, zone sovraesposte, riflessi; spesso viene progettato in modo specifico per l’utilizzo richiesto. E poi l’obiettivo, ovvero il sistema di lenti, che deve far arrivare al sensore un’immagine senza distorsioni, senza flare, perfettamente a fuoco e dove il soggetto sia inquadrato dalla distanza giusta, quindi usando una lunghezza focale appropriata. Infine, il “cervello”, ovvero la parte che elabora le immagini, ricava da esse le informazioni e le trasmette al cobot o ad altri computer che utilizzeranno i dati raccolti.

Un cobot su cinque ci vede

Per saperne di più sulla situazione attuale della machine vision applicata ai cobot, abbiamo parlato con Paolo Bassetti, head of technical support di Universal Robots Italia, l’azienda danese (ora di proprietà di Teradyne) che ha praticamente inventato il concetto di cobot e che detiene circa il 50% del mercato mondiale. Universal Robots ha realizzato un webinar in italiano sui sistemi di visione 2D e 3D (lo trovate qui) all’interno del quale sono descritte varie tipologie di videocamere e sono mostrati esempi di programmazione. Con Bassetti abbiamo poi approfondito alcuni aspetti pratici della piattaforma. La prima cosa che abbiamo chiesto è quanti sono i cobot che oggi vengono venduti dotati di dispositivi di visione, e come vengono usati. «Circa il 20% dei cobot che vendiamo vengono utilizzati insieme a un sistema di visione. Penso che il dato sia abbastanza simile anche per altri produttori» ci spiega Bassetti. «Un sistema di visione si usa per esempio quando devo fare controllo di qualità. Quindi se devo verificare che un pezzo sia formato correttamente, che non abbia graffi eccetera. Un altro utilizzo tipico è quando devo fare operazioni di assemblaggio e devo verificare dove si trova una certa parte, dove è posizionato un determinato foro e così via. Un terzo uso comune è l’asservimento macchine. Per esempio arriva un vassoio con vari pezzi alla rinfusa e la telecamera deve identificarli e passare al robot l’informazione su dove si trovano, in modo che il braccio possa afferrarli correttamente». Uno sviluppo recente è l’utilizzo di sensori 3D (in particolare Tof – Time of Flight, e in futuro 3D Lidar con il calo dei prezzi), per migliorare la percezione che ha il robot dell’ambiente che lo circonda, in modo da permettergli di reagire più rapidamente o in modo più appropriato ad eventuali anomalie. Per esempio oggetti estranei o persone che entrano nel suo raggio d’azione (questo soprattutto per robot montati su piattaforme mobili), recipienti di pezzi caduti inaspettatamente eccetera.

Che la machine vision sia perfetta per fare controllo di qualità è abbastanza ovvio, ma meno ovvio è il motivo per cui dovrei montare la videocamera su un braccio robotico invece di lasciarla fissa lungo il percorso dei pezzi da controllare. «Dipende da che tipo di controllo devo fare. Prendiamo il settore automotive, per esempio. Supponiamo di dover controllare alla fine della linea di montaggio un motore, il quale presenta una ventina di punti da verificare, posizionati in varie parti del prodotto. Il robot potrà portare rapidamente la telecamera a inquadrare ogni singolo punto dalla migliore posizione possibile, consentendo di eseguire la verifica di qualità in modo accurato e veloce».

La telecamera va aggiunta

Universal Robots non produce cobot già dotati di sistema di visione, e quindi il cliente deve scegliere e fare integrare il sistema con il braccio. Come mai questa scelta? «Il primo motivo di questa scelta è che se installo una telecamera fissa su un cobot, ho una componente di costo in più che nell’80% dei casi non verrà usata. In secondo luogo, ogni tipo di applicazione ha bisogno di una specifica telecamera, con risoluzione più o meno alta, con luci e obiettivi diversi. Quindi il nostro cliente potrà scegliere, in base alla sua applicazione, il sistema di visione più adatto fra tutti quelli che sono a disposizione». Questa scelta quindi garantisce la massima versatilità e la massima aderenza alle specifiche dell’applicazione da implementare. Ma chi si occuperà di tutto il lavoro di integrazione necessario fra videocamera, software e cobot? «Ci sono varie strade. Se il cliente si sta appoggiando a un system integrator, perché vuole una soluzione “chiavi in mano”, l’integratore sarà sicuramente in grado di selezionare la giusta soluzione e di assemblare il tutto. Ci sono poi clienti che preferiscono fare da soli. E la cosa è abbastanza semplice, se si ha l’accortezza di scegliere un sistema di visione fra quelli certificati UR+».

UR+ è il programma di certificazione di Universal Robots per gli accessori dei suoi cobot. I prodotti certificati trovano posto su una sorta di marketplace, Urcaps (lo trovate qui), che tratta sia componenti hardware, sia kit applicativi. Nel ricco catalogo troviamo davvero di tutto, dai sistemi di visione alle pinze, dalle soluzioni software per l’assemblaggio a quelle per la saldatura. Particolarmente interessanti sono le Caps (che sta per “capabilities”, ovvero “capacità”), che sono l’equivalente robotico delle App per gli smartphone, o di un driver per un Pc. Si tratta di moduli software sviluppati in Java, tramite un kit di sviluppo messo a disposizione gratuitamente da Universal Robots (lo trovate qui), che vanno caricati nel controller del robot. Le Caps possono essere programmi applicativi ma anche software dedicati a interfacciare specifici dispositivi con il cobot. Infatti ogni accessorio certificato Ur+ dispone di una propria Cap, la quale viene messa a disposizione su Ur+ per essere inserita nella piattaforma di sviluppo software del cobot, in modo tale da consentire al programmatore l’utilizzo delle funzionalità del dispositivo connesso.

«Se il sistema di visione è certificato Ur+ e quindi dispone della Cap, è sufficiente fare pochi passi tramite una sorta di wizard per avere a disposizione le varie funzionalità: localizzazione del pezzo, calibrazione della telecamera, passaggio delle coordinate al robot eccetera. E queste operazioni le può fare il cliente finale, senza necessità di grandi competenze. Per i sistemi di visione non certificati Ur+, invece, è necessario qualche passaggio in più ed è richiesta una certa competenza: bisogna definire bene i protocolli di comunicazione, i formati dei dati da passare, niente di straordinario ma si tratta di cose che in genere vengono seguite dal system integrator». Universal Robots in Italia arriva ai suoi clienti tramite 5 distributori, che si occupano di vendere non solo il cobot ma anche gli accessori – dalle pinze ai sistemi di visione. Tuttavia, di norma questi distributori non agiscono come integratori di sistema. Se dunque si vuole realizzare un sistema fortemente personalizzato e senza sfruttare le facilitazioni della certificazione Ur+, molto probabilmente si dovrà inserire un terzo attore nel processo di deployment del cobot. Potrebbe trattarsi, per esempio, del system integrator che sta progettando o ha progettato la linea di lavorazione. «In realtà, nella maggior parte dei casi basta una mezza giornata per montare un sistema con componenti certificate e farlo partire, per cui tipicamente il distributore segue direttamente il processo. L’integratore è richiesto solo quando si vogliono fare installazioni particolari e con prodotti non certificati, sempre che il cliente non decida di sviluppare competenze interne per configurare la macchina da solo». Questa possibile scelta non è poi così strana, perché soprattutto in aziende di medie dimensioni detenere internamente un know-how specifico sull’implementazione di sistemi robotici può dare un vantaggio competitivo sulla concorrenza. Di solito si tende a formare piccoli gruppi di lavoro specializzati, che provvedono sia al deployment di nuove macchine, sia alla riconfigurazione e riprogrammazione dei sistemi presenti in fabbrica, quando essi devono essere riallocati su nuovi compiti o nuove linee. Contare su risorse interne inoltre abbrevia ulteriormente i tempi necessari a riassegnare un cobot a un nuovo task.

«Un fattore che influenza la scelta è anche dove si trova la complessità. Se è sulla telecamera, che per esempio deve riconoscere particolari difetti di un componente, o deve fare analisi complesse, allora il problema non è l’installazione del robot ma il software della telecamera. In questi casi in genere il cliente si rivolge direttamente al produttore della telecamera, che si occuperà di definire i protocolli, eccetera. Alla fine, il software passerà al robot semplicemente l’informazione sull’idoneità del pezzo e il cobot provvederà a tenerlo o scartarlo di conseguenza, con un software molto semplice, e a questo punto non è necessario che ci sia un integratore a fare il lavoro».

Il programma di certificazione Ur+

Vista la differenza di complessità nell’utilizzo di sistemi di visione certificati Ur+ o non certificati, è chiaro che per il cliente finale sia preferibile rivolgersi a prodotti che siano nel marketplace. Ed è anche abbastanza ovvio che per i produttori di sistemi di visione (e in generale di accessori per i cobot) ottenere la certificazione Ur+ sia una valida mossa per incrementare le vendite, anche considerato che Universal Robots ha in mano metà del mercato mondiale. Ma come funziona il processo di certificazione, e cosa bisogna fare per farsi certificare? «Qualunque azienda può produrre un sistema compatibile con i nostri cobot. Ci sono tre cose da fare. Bisogna garantire la compatibilità meccanica, fornendo accessori di montaggio con le giuste misure; garantire la compatibilità elettrica, utilizzando il giusto connettore per collegarsi a quello sul polso del robot o a quello all’interno del quadro; e soprattutto bisogna sviluppare questo software per la piattaforma Ur+, che permette di interfacciare la telecamera con il robot». Il software è praticamente una serie di Api che permette di gestire tutta la configurazione della telecamera, e di interfacciare le funzionalità del sistema di visione con il software di programmazione del cobot, che è di tipo visuale e permette di programmare il cobot “addestrandolo”, ovvero mostrandogli i movimenti che deve fare. Per esempio, se devo riconoscere la posizione di un pezzo, il software dirà all’operatore “porta il robot nel punto dove devi fare la foto”, l’operatore lo sposterà in posizione e premerà un tasto, oppure “metti sotto la griglia di calibrazione”, “porta il robot a prendere il pezzo nella posizione prevista”, e così via. In questo modo, l’operatore con una serie di passaggi costruisce un albero di programma con una serie di nodi funzionali che il cobot potrà poi replicare in autonomia. Se le funzioni richieste sono quelle “basiche”, questo è tutto ciò che serve per interfacciare la telecamera con i cobot. Se invece sono richieste funzioni più sofisticate, per esempio misurazioni particolari e altro, allora sarà necessario sviluppare un software specifico che poi girerà sulla telecamera e che andrà a comunicare con il software di gestione del cobot. In questo caso, tipicamente, interviene o direttamente il produttore della videocamera, o un integratore. Un’altra possibilità è di utilizzare librerie sofisticate di visione artificiale, eventualmente in aggiunta a quelle standard della telecamera. Un esempio di utilizzo sofisticato arriva proprio dalla sede italiana, dove una studentessa del Politecnico di Torino sta preparando per una tesi un software che permette al cobot di riconoscere un operatore umano, sfruttando le librerie open source OpenCV (Open Computer Vision library).

«Una volta preparato il tutto, parti meccaniche, elettriche e software, l’intero pacchetto va spedito alla nostra sede in Danimarca dove i nostri tecnici verificano che tutte le componenti siano compatibili, che tutto funzioni correttamente, e che non ci siano problemi di compatibilità con altre Urcaps. Per esempio potrei aver installato quelle della pinza e della telecamera, e devono andare d’accordo fra loro. Se tutto va bene, viene emessa la certificazione e l’accessorio viene inserito nel sito Ur+, che funziona come vetrina di tutti i prodotti certificati». Una caratteristica atipica del marketplace di Universal Robots infatti è che non è un sito di vendita. Potremmo dire che del negozio online c’è solo la vetrina. Il che significa anche che l’azienda non percepisce percentuali sulla vendita di accessori certificati. «Per ogni prodotto forniamo sul sito i link alla casa produttrice, dove il cliente potrà rivolgersi per avere informazioni più dettagliate e per procedere all’acquisto. Noi come Universal Robots non vendiamo alcun prodotto Ur+. Alcuni nostri distributori però hanno scelto di vendere anche alcuni prodotti Ur+, ma è una loro libera scelta, dettata dal fatto che spesso sanno che, per il loro mercato, un certo tipo di pinza o di videocamera è richiesta frequentemente dai loro clienti».

Il futuro è l’intelligenza artificiale

Come accade sempre più spesso, la chiave del successo delle soluzioni di visione robotica sta principalmente nel software di gestione. E se usare prodotti certificati, quindi dotati di Caps, rappresenta una semplificazione per chi dovrà programmare il cobot, l’industria in realtà sta andando oltre, e la nuova frontiera è l’impiego dell’intelligenza artificiale applicata ai sistemi di visione. «Alcune aziende stanno sviluppando algoritmi grazie ai quali, per esempio, se la telecamera inquadra un vassoio con degli oggetti non devo andare a programmare quale pezzo il robot deve prendere: posso mostrare al robot quello che deve fare, muovendolo, oppure posso lasciare che sia il software di visione a comprendere mano a mano la forma degli oggetti e quindi a cercare di ottimizzare la modalità di presa, l’orientamento eccetera. Nei prossimi mesi vedremo quindi applicativi che prevedono meno programmazione esplicita e più analisi automatica da parte del software della telecamera». Oltre all’intelligenza artificiale si sfrutteranno di più anche tecniche di machine learning. Per esempio, per il controllo qualità si potrà mostrare alla telecamera un certo numero di pezzi “validi”, e il software di machine learning apprenderà le loro caratteristiche, e imparerà quindi a scartare i pezzi che non le rispecchiano.

Ma al di là dei software di Ai e di Ml, il trend di adozione delle tecnologie di visione robotica è in crescita. «Non abbiamo dati precisi in merito, ma ci sembra un fenomeno in crescita, per due motivi. Il primo è che le tecnologie delle telecamere e del software si stanno evolvendo rapidamente, e quindi migliorano tutti i dati che le telecamere passano, la precisione, la velocità. Il secondo è che stanno scendendo i prezzi: una telecamera che qualche anno fa costava 5mila euro, ora la si acquista con un migliaio. E quindi sta diventando più conveniente installare una telecamera invece che costruire un sistema meccanico per fare la stessa operazione. Se aggiungiamo anche la facilità di programmazione, è chiaro che la cosa fa gola. In più, un’altra applicazione che si sta sviluppando tantissimo e presto esploderà è quella del 3D, per esempio il bin-picking, ovvero la presa di oggetti da cassone. Pensi di avere una cassa piena di oggetti, e che il sistema di visione del robot debba individuare i singoli oggetti da prendere, che non sono su un piano ma possono avere qualsiasi orientamento nello spazio tridimensionale. E quindi la telecamera dovrà capire se il pezzo è libero o bloccato da altri, come è posizionato, qual è l’angolo di presa migliore, qual è la traiettoria di approccio migliore per evitare di sbattere contro le pareti della cassa. Cose di questo tipo pochi anni fa costavano centinaia di migliaia di euro, oggi con 30mila euro si possono acquistare sistemi del genere». Meno del costo annuo dell’operaio che dovrebbe estrarre i pezzi ed allinearli manualmente. E che probabilmente non potrà raggiungere la fabbrica al prossimo lockdown.