Il Tecnopolo di Bologna, parco scientifico dell’innovazione promosso dalla Regione Emilia-Romagna e supportato da investimenti del governo italiano e della comunità europea, diventa il cuore della data valley italiana. Ospita il data center del centro meteo europeo, il competence center Bi-Rex ed è ora pronto ad accogliere il supercalcolatore Leonardo. Sarà up and running entro la fine dell’anno e verrà gestito dal Cineca, il consorzio interuniversitario, centro di eccellenza mondiale del supercalcolo, cui spetta un ruolo di rilievo nel contesto del Centro Nazionale di ricerca in high performance computing, big data e quantum computing coordinato dall’Istituto nazionale di fisica nucleare (Infn) e istituito dal governo secondo quanto previsto dal Pnrr. 30 tir, 157 rack, 4.993 server, per un totale di 360.000 chili di peso e centinaia di chilometri di cavi.

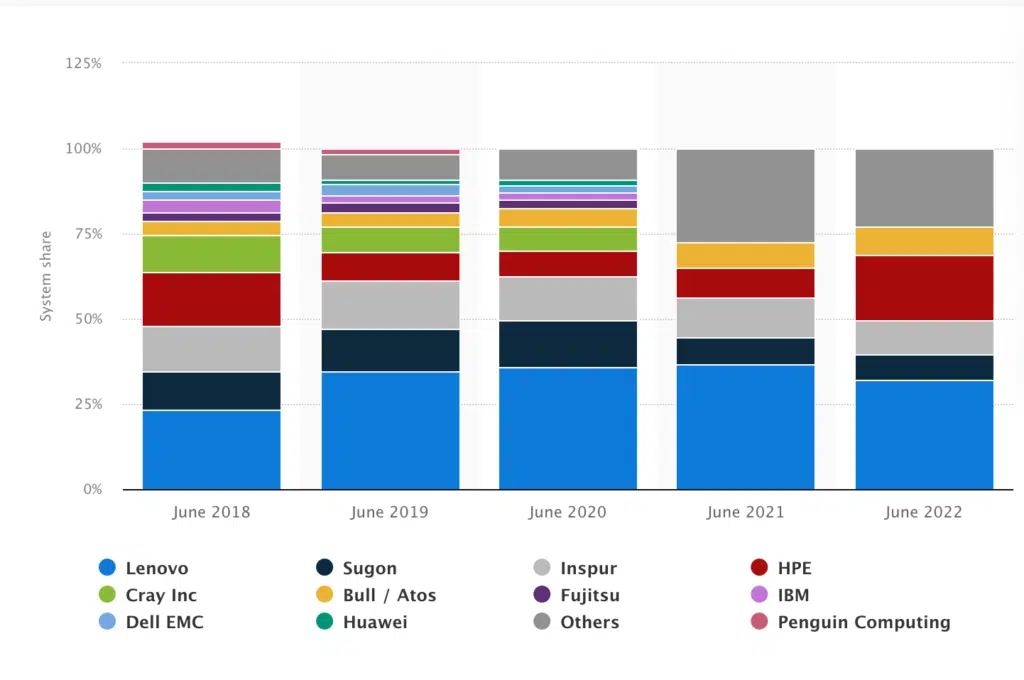

Mentre nella pianura padana si registravano temperature superiori ai 40 gradi sono iniziati ad arrivare a Bologna i primi componenti della macchina monster. Basato su tecnologia della francese Atos, società quotata alla borsa di Parigi, leader europeo del supercomputing e un fatturato di 11 miliardi di euro, avrà una potenza computazionale di 250 milioni di miliardi di operazioni al secondo (250 petaflops) – 10 volte la potenza di calcolo dell’attuale Marconi 100 (il sistema di punta del Cineca) – e oltre 100 petabyte di capacità di storage. «Sono numeri che dovrebbero permettere di posizionarci al quinto posto della classifica mondiale del supercalcolo, afferma Sanzio Bassini, direttore del dipartimento supercalcolo di Cineca. Nel mondo industriale il consorzio vanta collaborazioni con imprese che operano nei più diversi settori (Altran, Amet, Chiesi farmaceutici, Dallara Automobili, Elica, Ferretti Yachts, Nolan, Olsa e Unipol).

Importanti progetti per l’analisi aerodinamica e fluidodinamica sono stati inoltre avviati con la sezione corse di Ferrari, per Piaggio Aero, Pilatus Aricraft, Tetrapack e Alenia Aeronautica. Tra le partnership industriali, anche quella con Eni che si avvale dell’hpc nell’ambito di attività legate all’estrazione degli idrocarburi. Grazie ai potenti sistemi di calcolo e a sofisticati algoritmi, Eni è in grado di analizzare dati geofisici in tempi ridotti e di produrre risultati qualitativamente più accurati. In questo modo viene aumentata la probabilità di successo dei pozzi di esplorazione, ridotti i tempi di messa in produzione dei giacimenti e aumentata la quantità degli idrocarburi estratti. Ecco il futuro e le sfide del supercalcolo italiano.

Hpc e Leonardo, un’infrastruttura unica al mondo e strategica per il futuro del Paese e dell’Europa

Oltre alle discipline scientifiche tradizionali, come fisica, astrofisica, chimica e fluidodinamica, Leonardo avrà il compito di affrontare progetti di frontiera, come la medicina personalizzata, il cambiamento climatico, la ricerca di nuove fonti di energia, lo sviluppo di nuovi materiali e la bioingegneria. Una parte delle risorse sarà anche destinata allo sviluppo di progetti industriali basati sull’intelligenza artificiale, sul digital twin e sulla simulazione di impianti e processi in logica predittiva. Costruire un’infrastruttura di supercalcolo italiana, aggregare le risorse di ricerca e di innovazione nei settori maggiormente strategici, posizionarsi come la piattaforma nazionale a supporto di iniziative scientifiche e industriali. A livello nazionale la potenza di Leonardo va a sommarsi a quella di Marconi100 di Cineca (32 Pflops), del Davinci-1 (l’hpc dell’ex Finmeccanica meccanica Leonardo, 5 Pflops), dell’Hpc5 di Eni (50 Pflops) e del supercomputer Franklin dell’Istituto Italiano di Tecnologia di Genova. «Con Leonardo, e la costituenda rete di nodi di supercalcolo, si favorirà la competitività di industrie di interesse nazionale, dice Bassini. Eni, Leonardo, Fincantieri, Snam, Ferrovie dello Stato, i grandi gruppi farmaceutici e automotive, tutte le aziende che aderiscono all’iniziativa del Centro Nazionale avviata dal Governo sono hpc dipendenti».

L’obiettivo di Cineca è essere la leva abilitante soluzioni supercalcolo che possono nascere dalla ricerca scientifica e Leonardo, la cui più grande ambizione è dare vita al gemello digitale della Terra, sarà la macchina che sosterrà le sfide dei big data. Il supercomputer è cofinanziato con 240 milioni di euro: 120 arrivano dalla Commissione Europea e 120 dal Miur. «Si tratta di un’infrastruttura unica al mondo e strategica per il futuro del nostro Paese e per l’Europa, dice Bassini. L’investimento servirà alla creazione di un ecosistema a livello internazionale. Rafforzerà la competitività italiana, contribuendo alla leadership dell’Europa nel settore dell’high performance computing». In un futuro ormai prossimo, le attuali architetture evolveranno verso soluzioni di tipo ibrido: includeranno tecnologia scalare o accelerata e quantum computing. «Vi saranno acceleratori che continueranno a sfruttare le attuali cpu e gpu, altri che sfrutteranno tecnologie neo-morphing e quantistiche, aggiunge Bassini. Gli algoritmi del futuro utilizzeranno in simultanea queste diverse tecnologie. La generazione successiva a Leonardo verrà realizzata nei prossimi dieci anni e troverà spazio nel Tecnopolo di Bologna».

Leonardo e il network nazionale di high performance computing

Compito del Centro Nazionale del supercalcolo, gestito dalla fondazione Icsc e coordinato da Infn, è mettere in rete e a sistema le specifiche conoscenze, competenze e risorse di realtà hpc che operano in tutta Italia in molteplici ambiti. L’obiettivo è costruire un’infrastruttura distribuita che supporti la ricerca scientifica e il mondo produttivo nell’innovazione e digitalizzazione del Paese. Si focalizzerà sul mantenimento e il potenziamento delle infrastrutture big data attuali e sullo sviluppo di metodi e applicazioni numeriche avanzati e di strumenti software per integrare il calcolo, la simulazione, la raccolta e l’analisi di dati, anche attraverso approcci cloud e distribuiti.

L’investimento, che si avvale di fondi Pnrr ed è pari a 320 milioni di euro, sarà l’occasione per creare nuove infrastrutture al sud, cui sono destinati circa 130 milioni, un contributo non indifferente per colmare il gap digitale con il nord. «La gestione dei big data è diventata una priorità per la quale sono necessarie ingenti risorse di calcolo e algoritmi e modelli matematici e statistici sempre più performanti. In questo contesto, il supercalcolo, le simulazioni numeriche, l’intelligenza artificiale e il machine learning sono strumenti essenziali per incentivare nuovi sviluppi sia da parte del mondo industriale che della ricerca scientifica», afferma Bassini.

Rete distribuita e condivisa di supercomputer per lo sviluppo industriale di grandi aziende e pmi

Il Tecnopolo di Bologna offre una dimensione di scale-up completamente diversa rispetto all’area di Casalecchio dove risiede l’attuale center Cineca. Permette di disporre di 10 megawatt, la potenza necessaria per alimentare Leonardo. In prospettiva, si potrà arrivare a 20 megawatt. Saranno indispensabili per far funzionare le generazioni di supercomputer che saranno disponibili tra una decina d’anni. «Prevediamo di avere Leonardo pienamente funzionante entro la fine ottobre in modo tale da partecipare al benchmark “ranking top 500” che stabilisce la classifica dei più potenti supercomputer al mondo», racconta Bassini. Leonardo è il nodo più importante del network hpc che andrà a costituirsi a livello nazionale. «Nuovi sviluppi prevedono la creazione di un supercomputer a Napoli, dice Bassini. Sarà una rete hpc federata con una piattaforma digitale condivisa per indirizzare situazioni estreme come terremoti, tsunami e pandemie».

Il network potrà compensare picchi di produzione quotidiana e migliorare l’efficacia della risposta dei singoli nodi di rete. Insomma, un vero cloud di supercomputing a livello nazionale. «L’hpc è una leva imprescindibile per supportare le aziende nel concettualizzare ed elaborare i proof of concept, ovvero gli studi di fattibilità di progetti, dice Bassini. La presenza di un’infrastruttura di supercalcolo è la base per diffondere una conoscenza nelle grandi ma soprattutto nelle piccole e medie aziende. E’ in questa prospettiva che si cala, per esempio, la collaborazione con Bi-Rex, il centro di competenza dell’Emilia-Romagna per il trasferimento tecnologico».

Supercomputing, risorsa che il Pnrr considera infrastuttura strategica nazionale

«In tutti gli scenari in cui si affrontano grandi sfide scientifiche che necessitano di una simulazione con analisi di grandissimi volumi di dati la potenza di calcolo ordinaria, anche hyperscaler, non è sufficiente, spiega Bassini. Progettare un aereo che funziona con energia all’idrogeno o un nuovo farmaco? In tutti questi casi occorre procedere con una simulazione che richiede la potenza e la logica computazionale che appartiene al supercomputing. Non esiste grande industria manifatturiera che non disponga di risorse hpc. Le aziende che vogliono competere per una posizione di leadership a livello globale devono poter fare affidamento su piattaforme di supercomputing, risorsa che il Pnrr considera come asset strategico per lo sviluppo industriale». Ecco, quindi, l’intenzione di rendere possibile l’accesso al network di nodi hpc del centro nazionale del supercalcolo, anche a piccole e medie aziende che lavorano su tecnologie avanzate, spesso in filiere dove simulazioni e big data sono la norma, come l’automotive, l’aerospace, l’oil & gas e il farmaceutico.

La transizione ecologica? E’ possibile solo con investimenti in transizione digitale

«E’ importante essere consapevoli che i sistemi sono di per sé complessi, spiega Bassini. Come si fa a risolvere il problema dell’inquinamento da rifiuti? Occorre capire come si comportano i materiali. La questione va posta in termini di soluzioni di economia circolare, che non significa raccolta differenziata ma utilizzo di materiali per fare altro. E la conoscenza dei materiali la si può acquisire solo con la simulazione numerica della dinamica molecolare. Bisogna arrivare agli atomi e alle sub-particelle. Senza questo si rimane alla superficie delle cose». Insomma, per creare innovazione il digitale lo si deve vedere a un livello più alto di quello ordinario. Sostenibilità equivale a sottrazione di Co2 ed è con la simulazione e i gemelli digitali che si possono immaginare nuovi scenari di economia industriale.

«Non si possono fare gli esperimenti, spiega Bassini. I modelli teorici vanno trasformati in simulazione numerica. Le equazioni sono espressione di una conoscenza di un fenomeno fisico mentre la simulazione consente di prevedere il comportamento di un certo modello o equazione in contesti sconosciuti. Addestrare un sistema di guida autonomo, per esempio. Non significa avere un percorso tracciato da un navigatore, ma la capacità di reagire ad aventi che accadono e che deriva da una metodologia che nasce dalla simulazione di uno scenario fisico. La scala di complessità è vastissima. Una cosa è mettere a punto un algoritmo che viene messo a bordo di una lavatrice per ottimizzare l’uso dell’acqua, ciclo di apprendimento che può essere risolto con l’elaborazione di un centinaio di casi, altra cosa avere la predizione della risposta terapeutica a un farmaco, che deve essere validato su un numero di casi estremo».

Hyperscaler, hpc, intelligenza artificiale e algoritmi predittivi

Amazon, Google, Microsoft. Ma l’infrastruttura cloud degli hyperscaler non è già in grado di soddisfare esigenze di data processing comparabili a quelle di un computer come Leonardo? «Le logiche sono sostanzialmente diverse, spiega Bassini. In un’architettura hyperscaler si utilizzano meccanismi di data reduction con traiettorie autonome e non integrate tra loro. Questo implica che ogni processore lavora su un singolo e indipendente processo mentre in un sistema di supercalcolo tutti i processori lavorano su uno stesso processo». Riguardo poi all’uso dell’intelligenza artificiale, Bassini fa la seguente riflessione: «Se si è capaci di descrivere un fenomeno con un sistema di equazioni, l’intelligenza artificiale non serve a nulla. Basta un calcolo deterministico. E’ sui fenomeni dove non esiste la conoscenza completa che si deve entrare nel merito di una simulazione “Ai based”: osservo un fenomeno, e se questo mi da una certa conferma, pur non sapendo qual è l’equazione che me lo può descrivere, seguo la predizione del modello algoritmico. E’ quello che la comunità scientifica definisce combinazione di modelli espliciti e impliciti: i primi, basati su una conoscenza deterministica, hanno un potere limitato sulle previsioni, che possono invece nascere dalla simulazione dei dati acquisiti».

Il futuro del Tecnopolo di Bologna, culla della data valley emiliana

Al Tecnopolo dell’ex Manifatttura Tabacchi di Bologna oltre all’high performance computer Leonardo, gestito dal Cineca, e al data center del centro europeo per le previsioni meteorologiche è presente il centro di competenza Bi-Rex, focalizzato sul big data. Nella stessa area troveranno casa il data center dell’Istituto Nazionale di Fisica Nucleare (Infn), la nuova agenzia dell’Enea, l’Istituto Nazionale di Astrofisica, le biobanche dell’Istituto Ortopedico Rizzoli e l’Arpae, l’agenzia regionale per la prevenzione in ambito di ambiente ed energia. Nell’ex Manifattura Tabacchi verranno ospitate anche attività connesse alla grande iniziativa europea Destination Earth: un progetto di grandi dimensioni, con sviluppi importantissimi sull’attività di ricerca e sulle applicazioni nei diversi ambiti scientifici, geografici, del territorio, con una piattaforma federata di modellazione e simulazione basata sul cloud, che fornirà l’accesso ai dati e alle applicazioni e che integrerà i digital twin, repliche digitali di vari aspetti del sistema Terra, come le previsioni meteorologiche e i cambiamenti climatici, la sicurezza alimentare e idrica, la circolazione oceanica globale e la biogeochimica degli oceani.