La platea degli utenti del supercalcolo si sta rapidamente allargando negli ultimi anni. Ai tradizionali utilizzatori di queste macchine, tipicamente laboratori militari e industria aerospaziale, si stanno aggiungendo aziende che fino a poco tempo fa non avrebbero mai considerato l’adozione di sistemi Hpc, dal manufatturiero alle life sciences passando per le catene del retail. A portare nuovi utenti al supercalcolo due fattori concomitanti. Da una parte l’emergere di nuovi workload, molti dei quali legati all’industria 4.0: dal Cad/Cae per la progettazione alla simulazione di macchine e sistemi complessi (prototipazione virtuale, digital twin), dall’analisi di big data (manutenzione predittiva, previsione delle vendite) al training di sistemi di intelligenza artificiale (automobili a guida autonoma, interpretazione del parlato per call center).

Dall’altra parte il rapido calo dei costi, che ha portato i sistemi Hpc entry level a tiro delle medie aziende. Senza contare che con le formule “as a service” o “pay per use” lo scalino d’ingresso è stato praticamente azzerato, consentendo anche a piccole realtà specializzate, dagli studi di ingegneria ai service di data scientist, di dotarsi di infrastrutture di supercalcolo. Infine, la disponibilità di librerie di software specializzate, sviluppate da università, istituti di ricerca e produttori di hardware, e spesso disponibili in modalità “open source”, ha reso più semplice la programmazione di queste macchine, che prima richiedeva conoscenze approfondite e non universalmente disponibili. Con l’allargarsi della platea degli utenti, si sono diversificate le esigenze, e oggi i maggiori produttori hanno in portfolio soluzioni pensate per diversi profili di utilizzatori, e capaci di scalare facilmente.

Lenovo amplia la gamma di server Hpc

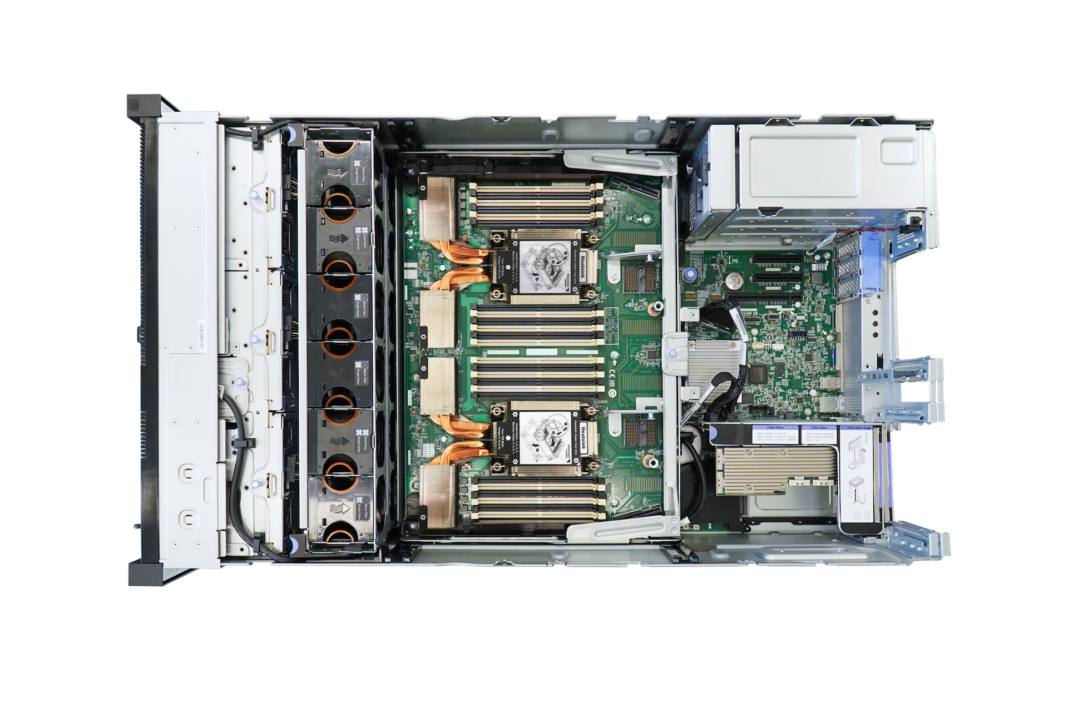

Lenovo ha recentemente aggiunto due nuovi modelli di server alla sua linea di macchine da supercalcolo. A giudicare dai nomi, le due nuove unità solo semplicemente un refresh di macchine già in produzione, ovvero gli Sd650 e Sr670. Ma in realtà non è proprio così. «Processori nuovi, refresh tecnologico, ma la vera novità è la densità di Gpu – conferma Roberta Marchini, Emea product director Data Center Group di Lenovo – I nuovi workflow di Hpc e intelligenza artificiale richiedono potenza di calcolo non solo dai processori ma anche un’assistenza dalle Gpu. Quindi il progetto di questi due server è stato fatto proprio tenendo presente la necessità di scalare sul numero di Gpu installabili». L’Sd650 è studiato per essere usato in grandi cluster e necessita del raffreddamento ad acqua, mentre l’Sr670 punta a soddisfare clientele con esigenze di workload inferiori e può essere installato in data center meno attrezzati.

L’introduzione di queste macchine prosegue il modus operandi di Lenovo, che cerca di soddisfare le esigenze dei clienti utilizzando le migliori tecnologie sul mercato – o proponendone di proprie nel caso veda la possibilità di creare maggiore valore rispetto all’esistente. In questo caso, il maggiore valore si raggiunge integrando i processori Intel con i moduli di calcolo prodotti da Nvidia, per i quali è disponibile e in continua crescita un vasto ecosistema di soluzioni software. Anche le nuove soluzioni di supercalcolo sono disponibili all’interno del programma TruScale, il pay per use di Lenovo, con formule fortemente personalizzabili per il cliente e per i partner coinvolti. Come in tutti i servizi in pay per use, il costo è determinato sulla base di un fisso più una quota variabile in base alle risorse impiegate e ai servizi richiesti, ma questi ultimi possono essere modulati in vari modi a seconda che se ne faccia carico direttamente Lenovo o, in tutto o in parte, l’eventuale partner (system integrator, software house eccetera) che segue il cliente finale.

Le nuove macchine

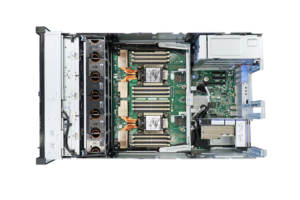

Come sono caratterizzate le due nuove macchine? Secondo Marchini, «L’Sd650 V2 è più orientato ai grandi cluster, perché consente di raggiungere potenze di calcolo fino a 3 PetaFlops, è completamente raffreddato a liquido e ospita fino a 4 Gpu Nvidia 100. Il raffreddamento ad acqua è utilizzato perché a parità di potenza riduce il consumo fino al 40%. L’Sr670 V2 è pensato per carichi un po’ più entry level, scala fino a 160 TeraFlops, e ospita fino a 8 Gpu di tipo Nvidia A100 o Tesla T4 nello chassis alto 3 unità». In effetti, l’interno del nuovo Sd650 V2 è completamente diverso dal suo omonimo della prima serie, che era equipaggiato con 4 processori Intel Xeon della vecchia generazione. Nel nuovo 650 troviamo due Cpu Xeon di terza generazione, e 4 Gpu Nvidia Hgx A100 Tensor Core collegate via NVLink, il bus di interconnessione specializzato di Nvidia per far comunicare fra loro le schede grafiche eliminando il collo di bottiglia del bus Pci. Questo tipo di connessione, combinata con il collegamento InfiniBand fra più macchine, consente di scalare efficientemente il sistema fino a migliaia di Gpu sullo stesso workload; ma è anche possibile al contrario sfruttare la tecnologia Mig (Nvidia Multi-Instance Gpu) che consente di partizionare le schede A100 in sette istanze separate, per accelerare carichi di lavoro più piccoli.

Per mantenere le massime prestazioni, le unità Nvidia sono raffreddate ad acqua tramite una tecnologia Neptune di quarta generazione, che evita il thermal jitter – quel fenomeno a causa del quale le Gpu rallentano il loro clock quando la temperatura delle giunzioni approccia il limite di pericolo. Questo implica che l’Sd650 debba essere installato in data center provvisti dei sistemi di tubazioni per il raffreddamento cosiddetto “ad acqua calda”, con il quale si distribuisce ai server acqua di raffreddamento a una temperatura che, in ingresso, può arrivare senza problemi fino a 50 gradi, e che poi verrà portata a raffreddarsi in appositi scambiatori di calore passivi. Questo sistema consente di ridurre drasticamente i consumi rispetto agli impianti di raffreddamento basati sul condizionamento dell’aria e in generale su sistemi a compressione/espansione, notoriamente energivori, tanto da costituire fino al 40/50% della spesa energetica di un data center.

Ancora più marcate le differenze fra il vecchio e il nuovo Sr670. Anche qui troviamo due Cpu Xeon di terza generazione, ma il nuovo modello ha un ingombro di tre unità rack, contro le due del precedente, e questo gli dà la possibilità di ospitare fino a 8 Gpu a singolo slot da 150 Watt nella versione “base”, oppure 8 Gpu doppio slot da 300 Watt nella versione “dense”. Grazie agli 8 slot in standard Pcie 4, è possibile scegliere le schede all’interno della famiglia Ampere di Nvidia. In particolare, Lenovo offre tre modelli: la A40 Tensor Core, la A100 Tensor Core e la Hgx A100; quest’ultima monta ben 4 Gpu su una singola scheda, con interconnessione NvLink. A completare la macchina, fino a 2 Terabyte di Ram Ddr4, fino a 10 alloggiamenti per dischi Ssd (a seconda delle versioni) con Raid hardware opzionale e una scelta di configurazioni per le connessioni di rete ad alta velocità. Se non fosse un Hpc, osservando la macchina in versione “base” giureremmo di trovarci davanti a un server iperconvergente. Ma le particolarità hardware dell’Sr670 non sono finite. «Qui la novità è che la macchina è raffreddata ad aria, ma le schede Gpu sono raffreddate a liquido con la tecnologia Lenovo Neptune – spiega Marchini – In pratica, all’interno della macchina c’è un circuito che porta il liquido a raffreddare le Gpu e poi a raffreddarsi in un radiatore appositamente concepito. È un po’ un ibrido, che dà i benefici di efficienza del raffreddamento a liquido senza la necessità di installare le tubature nel data center. Anche questo lo rende adatto a carichi di lavoro più piccoli, perché può essere installato in data center che non dispongono degli impianti per il raffreddamento a liquido».

Gli utilizzi dei supercomputer

I nuovi server Lenovo sono pensati per offrire il meglio di sé nei settori dell’intelligenza artificiale, del supercalcolo e nei carichi di lavoro grafici in una vasta gamma di settori, dalla vendita al dettaglio alla produzione, dai servizi finanziari alla sanità, e in generale ovunque si possano sfruttare le Gpu per estrarre maggiori informazioni utilizzando il machine learning e il deep learning. Qualche esempio di carichi di lavoro tipici viene elencato nei data sheet dei nuovi server: training di modelli deep learning per auto a guida autonoma; visualizzazione remota per i team che lavorano da casa; rendering con ray tracing per grafica fotorealistica; codifica e decodifica di video ad alta velocità; elaborazione del linguaggio naturale (Pnl) per i call center; ispezione ottica automatica per il controllo di qualità; visione artificiale per l’esperienza del cliente al dettaglio; test e simulazioni immunologiche nelle life sciences.

Proprio nell’ambito delle life sciences Lenovo ha fatto recentemente un annuncio interessante, che esprime anche la filosofia di Lenovo: creare dove può dare valore, e allearsi quando c’è valore nell’alleanza. «Nell’ambito del Supercomputing 2020 abbiamo annunciato di aver lavorato su un’architettura di riferimento che si chiama Goast (Genomic Optimization and Scalability Tool), creata da Intel e dal Broad Institute per la ricerca e sequenziazione del genoma umano, e utilizzando la nostra tecnologia siamo riusciti a ottenere una performance migliore. È un esempio di come spesso non serva creare nuova tecnologia quando puoi ottimizzare quella esistente nell’ambito di un’alleanza. Le nostre divisioni di ricerca e sviluppo tengono sempre d’occhio i trend di mercato, e lo sviluppo di prodotti si basa anche sulle esigenze che i nostri clienti esprimono. In questo momento stiamo lavorando con Intel e Nvidia perché riteniamo siano i leader di mercato, e mediante queste alleanze costruiamo i sistemi. Gli annunci attuali riguardano l’utilizzo estensivo di tecnologie Gpu Nvidia, non escludo che in futuro possiamo elaborare qualcosa di diverso, ma al momento questi sono gli annunci. Noi sviluppiamo i sistemi basandoci non solo sull’hardware, ma anche sull’ecosistema software che c’è intorno. I vari framework di sviluppo, sia in ambito Hpc che in intelligenza artificiale, sono quelli che danno compatibilità e “guidano” lo sviluppo. Quindi prima di espanderci su altre piattaforme bisogna che ci sia un solido ecosistema per la componente software. Comunque teniamo d’occhio il mercato e lavoriamo per costruire le alleanze più utili per i nostri clienti».

Democratizzare il supercomputing

Fino a pochi anni fa avere accesso a un supercomputer poteva servire a poche decine di entità nel mondo. Parliamo dell’industria aerospaziale e automotive, dei laboratori per la ricerca sull’atomo, o dei grandi centri per le previsioni meteo. Oggi la situazione è diversa: con i nuovi workload, migliaia di aziende, anche piccolissime, hanno bisogno del supercalcolo. Purtroppo, molto spesso non hanno né le competenze necessarie per configurare e gestire un sistema, né budget sufficienti per permettersi tecnologie che hanno ancora un elevato costo di ingresso, e che magari in azienda saranno utilizzate in modo infrequente o discontinuo. Lenovo può offrire risposte anche a questa categoria di clienti. Secondo Marchini, «Il 670 ha un livello di ingresso più basso e permette di implementare un sistema con costi “entry level”, senza spendere milioni per avere un cluster efficiente. Per quanto riguarda la gestione, abbiamo un tool di ottimizzazione che si chiama Lico (Lenovo Intelligent Cluster Orchestrator) che consente l’accesso semplificato alla gestione dei cluster open source. Quindi consente di ottimizzare i carichi di lavoro delle varie attività, machine learning, deep learning, in modo da poter condividere le stesse risorse in maniera più semplice».

E poi c’è il pay per use, ovvero l’offerta del supercomputing “as a service” «Abbiamo un’offerta che si chiama TruScale ed è disponibile per tutti i tipi di architettura, non solo Hpc e Ai. In TruScale, a fronte di un costo mensile, Lenovo crea un’architettura di riferimento della quale mantiene la proprietà e la installa “on premise” dal cliente, occupandosi anche di gestirla da remoto. In questo modo il cliente vede i suoi costi passare da Capex a Opex, inoltre non ha più l’onere della gestione. Naturalmente ci sono vari livelli di servizio possibili, l’offerta viene modulata a seconda di quello che il cliente vuole ottenere. Il costo è costituito da una parte fissa che viene decisa con il cliente e da una parte variabile in base alle risorse utilizzate e al livello dei servizi richiesti, che possono andare da un semplice health check fino alla gestione completa da remoto».

Cresce il ruolo dei partner

Un’altra conseguenza dell’ampliamento della fascia di clienti potenziali delle macchine da supercalcolo è che i grandi produttori non lavorano più da soli con il cliente, e sta parallelamente espandendosi il ruolo dei partner. «Abbiamo dei partner di riferimento specifici per ogni Paese, alleanze a livello globale ma anche a livello locale. I nostri partner possono decidere a che livello lavorare con noi, se vogliono avvalersi di servizi chiavi in mano o se invece preferiscono fornire al cliente i loro servizi e fino a che livello farlo. Noi siamo in grado di fornire anche il rack già preconfigurato e di farlo installare da un nostro team di delivery, ma i partner possono decidere per esempio di avvalersi solo della parte infrastrutturale e poi costruire loro la parte di servizi. Un’altra cosa interessante è la possibilità per le imprese di collaborare con i nostri laboratori per creare delle proof of concept. Abbiamo dei centri, come quello di Stoccarda per l’Europa, dove possiamo aiutare il cliente a capire se un particolare workload può trarre beneficio da una determinata architettura, e a effettuarne correttamente il dimensionamento, calcolando quanti TeraFlops vengono effettivamente erogati per una specifica configurazione in uno specifico workload. Questo è un servizio di grande valore per i partner, che magari non hanno in casa le risorse per garantire un servizio del genere alla loro clientela».

(Ripubblicazione dell’articolo pubblicato il 23/12/2020)