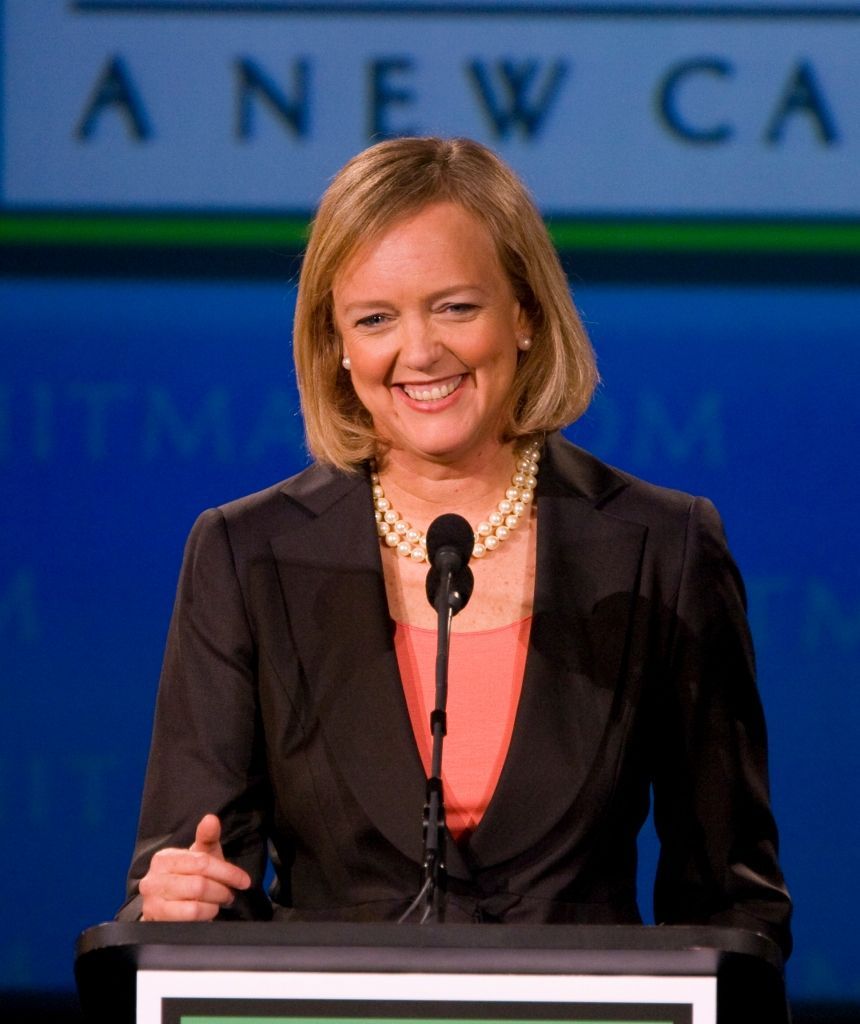

di Nicola Penna ♦ Dalla verifica delle targhe automobilistiche alla classificazione dei tessuti biologici, fino al riconoscimento facciale. Sono in continuo aumento le applicazioni per le supercapacità del computing. La multinazionale guidata da Meg Whitman ha annunciato una serie di novità

L’AI sta diventando mainstream nel settore consumer grazie ad applicazioni come interfacce vocali, assistenti personali e il tagging delle immagini. Tuttavia, le implicazioni dell’AI vanno al di là delle più diffuse casistiche di utilizzo consumer per entrare in campi come l’analisi per il sequenziamento genomico, le ricerche sul clima, la medicina, le vetture a guida autonoma e la robotica. Innovazioni e progressi tecnologici in queste aree sono stati, e continuano a essere, possibili grazie al deep learning. La multinazionale di Palo Alto (California), guidata da Meg Whitman, con 52 miliardi di dollari di fatturato e 240mila dipendenti, è leader nel settore dei server, storage, reti cablate e wireless, sistemi converged, software, servizi e cloud. Ora Hewlett Packard Enterprise ha annunciato nuove piattaforme e nuovi servizi su misura per aiutare le aziende a semplificare l’adozione dell’intelligenza artificiale, partendo proprio da questa importante area dell’AI (Artificial Intelligence) conosciuta come deep learning.

Concretizzare le potenzialità dell’ A.I.

Ispirato dal cervello umano, il deep learning viene tipicamente implementato per attività complesse quali il riconoscimento di immagini e volti, la classificazione di immagini e il riconoscimento vocale. Per poter sfruttare al meglio il deep learning, le aziende hanno bisogno di un’infrastruttura di calcolo ad alte prestazioni in grado di creare e addestrare modelli di apprendimento capaci di gestire grandi volumi di dati per riconoscere i pattern presenti nell’audio, nelle immagini, nei video, nei testi e nei dati provenienti da sensori.

Molte aziende non dispongono di tutti gli elementi necessari a implementare il deep learning, incluse competenze e risorse, sofisticate infrastrutture hardware e software su misura e capacità di integrazione necessarie ad assimilare i vari componenti hardware e software per poter scalare i sistemi AI. Per aiutare le imprese a superare questi ostacoli e concretizzare le potenzialità dell’AI, HPE ha messo a punto diverse proposte.

Le nuove soluzioni e i nuovi servizi

Si tratta sia di soluzione hardware e software che di attività di ricerca localizzate in differenti centri di innovazione dove si potranno incontrare le competenze di Università e aziende impegnate nell’ ambito dell’ A.I.

HPE Rapid Software Development for AI

E’ una soluzione hardware e software integrata appositamente realizzata per le applicazioni di High Performance Computing e deep learning. Basata sul sistema HPE Apollo 6500 realizzato in collaborazione con Bright Computing per consentire il rapido sviluppo di applicazioni di deep learning, comprende framework software preconfigurati, librerie, aggiornamenti software automatici e gestione dei cluster ottimizzata. La soluzione supporta le GPU NVIDIA® Tesla V100.

HPE Deep Learning Cookbook

Creato dal team AI Research di Hewlett Packard Labs, Deep Learning Cookbook è un set di strumenti che guidano nella scelta del miglior ambiente hardware e software per le diverse attività di deep learning. Sono tools che aiutano le aziende a stimare le performance delle varie piattaforme hardware, caratterizzare i più diffusi framework dedicati al deep learning e scegliere gli stack hardware e software ideali per le proprie esigenze individuali.

In aggiunta Deep Learning Cookbook può essere utilizzato per convalidare le performance e ottimizzare la configurazione degli stack hardware e software già acquistati. Una casistica di utilizzo presente nel Cookbook riguarda gli HPE Image Classification Reference Design. Questi reference design forniscono ai clienti configurazioni infrastrutturali ottimizzate per l’addestramento di modelli di classificazione delle immagini per vari fini, come la verifica delle targhe automobilistiche o la classificazione dei tessuti biologici. Questi design sono collaudati per garantirne le performance ed eliminare eventuali incertezze aiutando i data scientist e l’IT a essere più efficienti ed economicamente efficaci.

HPE AI Innovation Center

Ideati per progetti di ricerca a più lungo termine, questi centri per l’innovazione agiranno da piattaforma per la collaborazione sulla ricerca tra università, aziende operanti all’avanguardia nella ricerca sulla AI e ricercatori HPE. I centri, situati a Houston, Palo Alto e Grenoble, offriranno ai ricercatori di atenei e imprese l’accesso a infrastrutture e strumenti necessari per proseguire le iniziative di ricerca.

HPE Center of Excellence (CoE) potenziati

Studiati per assistere dipartimenti IT e data scientist che intendono accelerare le proprie applicazioni di deep learning e ricavare un ROI migliore dai deployment di deep learning nel breve termine, gli HPE CoE offrono ad aziende selezionate l’accesso alle ultimissime tecnologie e competenze, comprese le più recenti GPU NVIDIA sui sistemi HPE. I CoE si trovano attualmente a Houston, Palo Alto, Tokyo, Bangalore e Grenoble.

«Oggi viviamo in un mondo dove generiamo enormi quantità di dati, e il deep learning può aiutarci a ricavarne intelligence», ha dichiarato Pankaj Goyal, vice president, Artificial Intelligence Business di Hewlett Packard Enterprise. «Tuttavia un’unica soluzione valida per tutti non può funzionare: ogni azienda ha le proprie esigenze specifiche che richiedono un approccio particolare per avviare, scalare e ottimizzare l’infrastruttura in funzione del deep learning.» Nell’ambito di questa mission finalizzata ad aiutare a concretizzare l’AI per le aziende, HPE propone servizi per il consumo flessibile dell’infrastruttura HPE in modo da evitare l’overprovisioning, aumentare i risparmi finanziari e scalare verso l’alto o verso il basso, secondo necessità, così da soddisfare i requisiti dei deployment di deep learning.