Le nuove regole europee sull’IA? Non sono un limite ma un’opportunità per l’industria italiana. Alle imprese è dato per la prima volta un framework di riferimento nel quale muoversi per integrare e gestire una tecnologia che ha una capacità trasformativa dirompente sui processi produttivi. Ma che è anche caratterizzata da rischi che devono essere gestiti. L’UE ha battuto tutti sul tempo, con l’AI Act, approvato a larga maggioranza e in prima lettura dal Parlamento lo scorso 13 marzo.

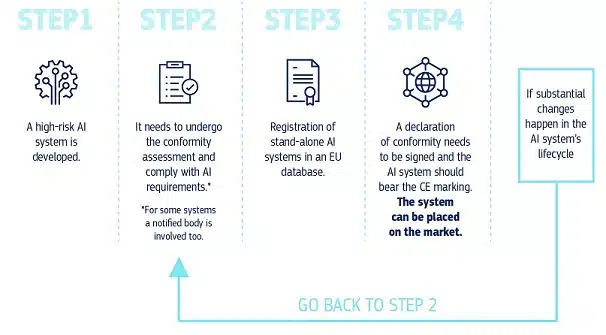

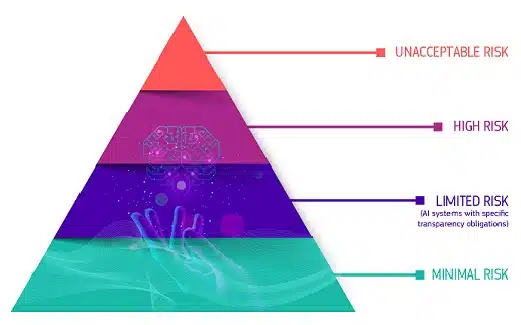

L’UE AI Act è la prima regolamentazione organica dell’utilizzo delle tecnologie basate sull’IA. Il principale elemento di novità sta nel fatto che mira allo sviluppo di un di un’intelligenza artificiale “affidabile e incentrata sull’uomo, garantendo, nel contempo, un elevato livello di protezione della salute, della sicurezza e dei diritti fondamentali sanciti dalla Carta dell’Ue”. Per realizzare questo obiettivo, le applicazioni dell’IA sono ricondotte a tre categorie di rischio, secondo lo stesso approccio della Gdpr, la direttiva sul trattamento dei dati. Alla prima categoria appartengono le IA inaccettabili (per esempio mirate allo scoring social) che sono vietate; quelle ad alto rischio perché possono causare danni potenziali alla salute, alla sicurezza, ai diritti fondamentali, all’ambiente, alla democrazia, e dunque saranno corredate da obblighi rigorosi (tra le altre, valutazioni di conformità, sistemi di gestione del rischio e di gestione della qualità, trasparenza): in questa categoria rientrano dispositivi medici, strumenti di reclutamento e gestione dei lavoratori e di gestione delle infrastrutture critiche. La terza categoria è quella dei sistemi a rischio limitato e a rischio minimo, per cui non ci sono obblighi particolari a carico delle imprese.

Inoltre, il regolamento ha un campo di applicazione vastissimo: si applicherà ai soggetti pubblici e privati, all’interno e all’esterno dell’UE, se ha effetti sul mercato o su persone situate nell’UE. Riguarderà sia i fornitori (ad esempio uno sviluppatore di uno strumento di screening dei CV) sia gli operatori di sistemi di IA (una banca che acquista lo strumento di screening dei CV). E gli importatori dovranno inoltre garantire che il fornitore straniero abbia già eseguito l’appropriata procedura di valutazione della conformità e che il sistema sia corredato della documentazione e delle istruzioni per l’uso richieste.

Per capire nel dettaglio cosa accadrà ora e quale sarà l’effetto delle nuove regole sull’industria italiana, abbiamo interpellato due esperti legali, Gerardo Giso, senior associate di Lexant e Massimiliano Pappalardo, socio dello studio legale Ughi e Nunziante.

Quello che emerge è che l’Act dell’UE sarà particolarmente rilevante per alcuni settori che utilizzano i sistemi di IA a elevato rischio: ovvero le infrastrutture critiche, e quindi le utility e i trasporti; ma l’impatto della compliance è dirompente anche sui servizi finanziari e bancari, e in generale sulla manifattura. Dirompente perché a fronte di un potenziale enorme richiede a tutte le aziende di adottare una governance ad hoc per integrare AI nei propri processi e per osservare una compliance stringente.

Le aziende dovranno assicurarsi, in altre parole, che i loro sistemi di intelligenza artificiale siano sicuri, trasparenti e non lesivi dei diritti degli utenti.

L’impatto dirompente dell’IA sull’industria: l’applicazione della tecnologia ai processi può far aumentare la produttività del 35% e ridurre del 14% il tempo dedicato alla singola attività. Ma per governarla c’è bisogno di regole

Uno studio recente realizzato in partnership da Mit e Stanford suggerisce che con l’intelligenza artificiale generativa la produttività possa aumentare fino al 35% e il tempo che i dipendenti dedicano alle attività possa essere ridotto fino al 14%. Upgrade che sono simili a quelli registrati con la prima rivoluzione industriale e non a caso l’IA viene spesso paragonata all’elettricità in termini di capacità trasformativa. Ma con una profondità e un’accelerazione che non hanno precedenti nella storia dell’industria. Inoltre, come è avvenuto con l’elettricità, che all’inizio veniva utilizzata in applicazioni per efficientare i processi in uso e poi ha generato nuovi processi e logiche produttive, oggi l’IA non è più solo un potenziatore di performance, ma può servire a cambiare i modelli di business. L’intelligenza artificiale può abilitare, per esempio, la servitizzazione delle industrie manifatturiere b2b e b2c. Non più venditori di prodotti, ma fornitori di servizi intorno al prodotto, con formule pay per use o pay per performance. Servizi che possono essere anche relativi al monitoraggio e alla manutenzione continua dei prodotti, se si sfruttano i sensori Iot con l’introduzione di tecnologie smart.

Il potenziale di una tecnologia del genere è enorme, ma lo sono anche i rischi. Per farvi fronte l’UE ha deciso di strutturare un complesso sistema di vigilanza su due livelli. Ma andiamo con ordine. Intanto, va rilevato che l’UE si è mossa rapidamente facendo seguire agli annunci azioni concrete in tempi record: il 24 gennaio è stato varato un pacchetto di misure a supporto di start-up e piccole e medie imprese per lo sviluppo di un’intelligenza artificiale affidabile. Il 21 febbraio è entrato in funzione L’Ufficio europeo per l’intelligenza artificiale (Eaio), il braccio operativo deputato alla vigilanza e di fatto all’attuazione del nuovo framework legale. Il 13 marzo, infine, il Parlamento Europeo ha direttiva europea sull’intelligenza artificiale. «L’AI Act rappresenta, senza ombra di dubbio, il testo normativo più avanzato al mondo in tema di intelligenza artificiale – dice a Industria Italiana Gerardo Giso, senior associate di Lexant – l’obiettivo è rimodulare il perimetro del tecnicamente possibile sulla base di quello che si ritiene giuridicamente ed eticamente accettabile. La legge è certamente figlia di una logica di compromesso e si poteva osare di più, ma mentre il resto del mondo rimane a guardare, l’Unione Europea ha battuto un colpo». Allora, vediamo quali sono le novità a maggior impatto.

Tutte le novità dell’AI Act: un ambito di applicazione che comprende tutti i possibili stakeholder, dai produttori dei sistemi tecnologici, ai fruitori, ai fornitori con sede fuori dall’UE (che possono vendere i loro prodotti solo se conformi alla norma europea)

Innanzitutto, le norme dell’AI Act si applicano: ai fornitori di sistemi di IA, indipendentemente dal fatto che siano stabiliti nell’Unione oppure in un paese terzo; agli utenti dei sistemi delle app diIA stabiliti nell’Unione; e ai fornitori e utenti dei sistemi di IA stabiliti in un paese terzo al di fuori dell’Unione, nella misura in cui detti sistemi interessino le persone situate nell’Unione.

«Ciò significa – spiega Giso – che i sistemi di IA sviluppati, ad esempio, negli Stati Uniti oppure in Cina potranno essere utilizzati e commercializzati sul territorio Ue solo se conformi alla disciplina comunitaria. L’AI Act, invece, non si applica ai sistemi sviluppati ovvero utilizzati esclusivamente per finalità militari o di ricerca».

L’approccio risk based mutuato dalla Gdpr: come funzionano i tre livelli di rischio e i diversi gradi di attenzione richiesti

Un secondo profilo di novità è costituito dall’approccio risk-based che permea l’intera disciplina. Questo in pratica si sostanzia nella previsione di un diverso trattamento giuridico dei sistemi a seconda dei rischi potenziali per i diritti fondamentali degli individui. «In particolare – precisa Giso – si distinguono le seguenti categorie: sistemi vietati (salvo eccezioni) in ragione dei rischi inaccettabili che possono comportare; sistemi ad alto rischio, per i quali si prevede una procedura di verifica di conformità a determinati requisiti di affidabilità; sistemi a basso o minimo rischio, per i quali è prevista la libera circolazione nel mercato, salvi alcuni obblighi di informazione che possono essere stabiliti a garanzia dell’utente finale».

«L’obiettivo dell’AI Act è promuovere un uso responsabile dell’intelligenza artificiale, per questo tiene in dovuta considerazione il grado di rischio che ciascun sistema di IA può comportare per i diritti fondamentali della persona – dice Massimiliano Pappalardo, socio dello studio legale Ughi e Nunziante – Tra i sistemi vietati vi sono, ad esempio, i sistemi di social scoring – tesi quindi a classificare le persone in base al proprio comportamento sociale ed alle proprie caratteristiche personali – o ancora sistemi volti a distorcere il comportamento delle persone attraverso tecniche di manipolazione o ancora a sfruttare le vulnerabilità dei più deboli».

Ma il testo dedica particolare attenzione ai sistemi ad alto rischio – presumibilmente quelli a maggiore diffusione – stabilendo che dovrà essere stabilito, implementato, documentato e mantenuto un sistema di gestione del rischio per identificare i rischi e adottare azioni di mitigazione durante l’intero ciclo di vita del sistema, eseguendo anche test per comprendere il funzionamento del modello in condizioni reali.

Ulteriori prescrizioni cui sono tenuti i produttori e distributori di sistemi di IA ad alto rischio riguardano:

- gli obblighi di trasparenza, documentazione (tecnica e d’uso) e rendicontazione agli utenti;

- l’obbligo di sorveglianza umana c.d. «aggravata», atta a prevenire, evitare e, se del caso, correggere errori ed aberrazioni dei sistemi di IA, prima che gli stessi arrechino gravi danni ai loro utenti;

- ulteriori obblighi in tema di gestione della qualità, disponibilità della documentazione tecnica, gestione di log automatizzati, informazioni da fornire, cooperazione con le Autorità competenti.

Chi controlla i controllori? Il doppio livello di vigilanza. L’organismo europeo della Commissione UE deputato alla valutazione della conformità e la rete di enti nazionali di certificazione e controllo

Nel radar dell’Eaio ci sono innanzitutto i modelli dell’IA generativa come ChatGpt: dovrà monitorarli per valutarne la conformità con gli obblighi previsti dal Regolamento, e per prevenire incidenti o effetti negativi con un impatto potenzialmente molto grave per i settori economici, la salute, la sicurezza, o i processi democratici.

Un’altra novità degna di nota sta nell’istituzione di un sistema di vigilanza completamente decentralizzata, su due livelli: un Ufficio per l’intelligenza artificiale all’interno della Commissione UE (il già citato European AI Office – Eaio) e una rete di organismi nazionali di certificazione e controllo. L’Eaio, che sarà interamente operativo entro la fine del 2024, dovrà garantire che l’AI Act venga applicata coerentemente in tutti gli Stati membri: opererà a Bruxelles all’interno della Direzione Generale che si occupa del digitale nella Commissione europea e sarà composto da funzionari ed esperti provenienti da tutta l’Unione.

Nel radar dell’Eaio ci sono innanzitutto i modelli dell’IA generativa come ChatGpt: dovrà monitorarli per valutarne la conformità con gli obblighi previsti dal Regolamento, e per prevenire incidenti o effetti negativi con un impatto potenzialmente molto grave per i settori economici, la salute, la sicurezza, o i processi democratici. L’Autorità dovrà vigiliare sul fatto che i contenuti artificialmente generati come i deep fake siano riconoscibili sia dall’utente che dai sistemi automatici di classificazione e ranking dei risultati (ovvero i browser).

Gli sviluppatori dei grandi algoritmi dovranno rispettare il diritto d’autore ma anche il loro diritto di scegliere che le opere del proprio ingegno non vengano utilizzate per l’addestramento degli stessi algoritmi. Queste competenze a monte sono a carico dell’Eaio, mentre quelle a valle sui prodotti e sistemi sono nella responsabilità degli Stati Membri.

L’equilibrio tra sviluppo tecnologico ed etica: la disciplina dei sistemi di IA generativi

L’AI Act disciplina anche i modelli fondativi – ovvero quei sistemi di IA in grado di svolgere compiti complessi, allenati da enormi quantità di dati (ad esempio, Gpt-4). Inoltre specifici obblighi di trasparenza sono previsti a carico di chi utilizza sistemi di AI destinati a interagire con le persone (Chatbot) o capaci di generare contenuti sintetici. «Si pensi ai cosiddetti “deep fake”, sempre più presenti nelle nostre vite. Chi genera o manipola contenuti di immagini, audio o video che costituiscono un “deep fake”, deve rendere noto che il contenuto è stato generato artificialmente», afferma Pappalardo.

Ma perché questa normativa è dirompente per le imprese? Cosa cambia in pratica? La prima risposta sta nella struttura stessa dell’atto che è volutamente rivolto a una platea vasta. «Il fatto che non si limiti solo agli sviluppatori di sistemi – dice Pappalardo – ma anche a chi li utilizza in ambito pubblico o privato rende gli effetti dell’Act pervasivi. Inoltre, un’altra eredità del Gdpr, è l’applicazione anche a organizzazioni extra europee, se il sistema di AI o i suoi output vengono utilizzati nel territorio Ue: insomma, nessun sistema di AI che entra in Europa potrà sottrarsi al vaglio delle nuove regole».

L’implementazione di soluzioni di IA richiederà, quindi, l’adozione di una governance a livello aziendale e l’osservanza di specifici adempimenti. «In particolar modo – continua l’esperto – le imprese che utilizzeranno sistemi ad alto rischio dovranno, ad esempio, adottare misure tecniche e organizzative adeguate ad assicurare un utilizzo di tali sistemi in conformità alle istruzioni dello sviluppatore, garantire un’attività di supervisione da parte di soggetti che abbiano le necessarie competenze ed un’adeguata formazione e selezionare i dati di input utilizzati per addestrare il sistema, in modo che siano pertinenti e sufficientemente rappresentativi».

Infrastrutture, energia e trasporti: i settori che subiranno il maggior impatto

Ci sono settori industriali che subiranno un impatto rilevante: energia, trasporti, infrastrutture critiche. «Sicuramente i settori più impattati sono quelli che vedranno un maggiore utilizzo di sistemi di IA ad alto rischio, tra cui vi sono, ad esempio, sistemi di intelligenza artificiale destinati a essere utilizzati come componenti di sicurezza nella gestione e nel funzionamento di infrastrutture digitali critiche – conferma Pappalardo – Quindi, in ambito privato, è prevedibile un impatto significativo per il settore delle utilities e per il settore dei trasporti». Tra i sistemi ad alto rischio sono anche inclusi i sistemi utilizzati per regolare l’accesso e la fruizione di servizi essenziali per il cittadino e, quindi, l’accesso all’assistenza sanitaria, al credito, ai servizi assicurativi, alle utility. «In particolare, in ambito bancario e assicurativo – continua Pappalardo – l’adozione di sistemi di intelligenza artificiale utilizzati ai fini della valutazione del rischio (ad esempio, sistemi di credit scoring o per la determinazione dei premi relativi a polizze assicurative sulla vita o sulla salute) dovrà essere anche preceduta da una procedura di Fundamental Rights Impact Assessment, volta ad assicurare l’adozione di misure idonee a garantire la tutela dei diritti fondamentali della persona; procedura che condivide obiettivi e struttura con la procedura di Data Protection Impact Assessment introdotta nel nostro ordinamento dal Gdpr».

AI Act: opportunità o vincolo?

In definitiva, l’AI Act fornisce le coordinate per capire cosa si può fare con l’IA e cosa non si può fare. Ma in nessun caso rappresenta un vincolo. «Per quanto talvolta il mercato sia allergico alle regole – in questo settore – avere un quadro di riferimento chiaro consente anche di eliminare le incertezze per le aziende intenzionate ad investire in questo settore – dice Pappalardo – Non credo, quindi, che la definizione di un perimetro di regole rappresenterà un freno per gli investimenti sull’AI. Potrà servire, invece, ad indirizzare il mercato verso investimenti orientati a promuovere un effettivo progresso».

Quello che, invece, potrebbe essere un limite è rappresentato dal fatto che l’AI Act non esaurisce gli obblighi ed i divieti che devono essere osservati dai soggetti che intendono adottare tali tecnologie. «Già leggendo i considerando dell’AI Act, balzano all’occhio le rilevanti normative di cui viene fatta salva l’applicazione, ad esempio in materia di privacy e di protezione del copyright – conclude l’esperto – Più in generale la rapida stratificazione normativa registrata negli ultimi anni a livello europeo ai fini della regolamentazione dei servizi digitali e dei dati – per quanto animata dalle migliori intenzioni – in assenza di un adeguato coordinamento rischia di generare un groviglio difficile da dipanare anche per gli addetti ai lavori, portando a un risultato opposto rispetto a quel quadro di regole certe a cui l’AI Act vorrebbe ambire».