di Marco Scotti ♦ Per la digital transformation e gli scenari data driven occorre l’architettura su misura. Il gigante dell’ IT ha un nuovo Ceo, Antonio Neri, nuove soluzioni, e un solo obiettivo: il miglior governo dei dati, con Hybrid It, Edge e Intelligenza Artificiale

È un momento di grandi cambiamenti per Hpe. Da un lato, l’annuncio dell’avvicendamento al vertice mondiale di Meg Whitman con Antonio Neri, argentino di origini italiane. Si tratta, dopo oltre un ventennio di CEO esterni, «di un veterano che ha vissuto una parte significativa della propria esperienza lavorativa all’interno della nostra azienda e che ha una fortissima inclinazione verso l’innovazione tecnologica» per dirla con le parole del CEO di Hpe Italia Stefano Venturi. Dall’altro, la decisione di puntare ancora più forte sul motto della stessa Whitman: “One size doesn’t fit all”. Che, al di là della traduzione letterale, significa puntare su un’ibridazione tra soluzioni cloud e on-premise per offrire alla clientela un mix completo di soluzioni per governare l’hybrid IT che si declina lungo tre direttrici: edge, core e cloud.

Le novità più significative per questo 2018 appena iniziato sono state presentate a Madrid il mese scorso, durante il tradizionale Hpe Discover, divenuto un appuntamento imperdibile per la presentazione della strategia dell’azienda. La parola chiave di questa edizione di Discover è Intelligent Edge, ovvero la capacità di acquisire, immagazzinare ed elaborare il dato dove lo stesso viene generato e che ha – secondo Hpe – maggiore sicurezza e minori costi per l’azienda. «Per fare raccolta dati in modo efficace – ha spiegato a Industria Italiana Venturi – è fondamentale che anche la periferia sia potente e, per questo, intelligente».

Hpe InfoSight

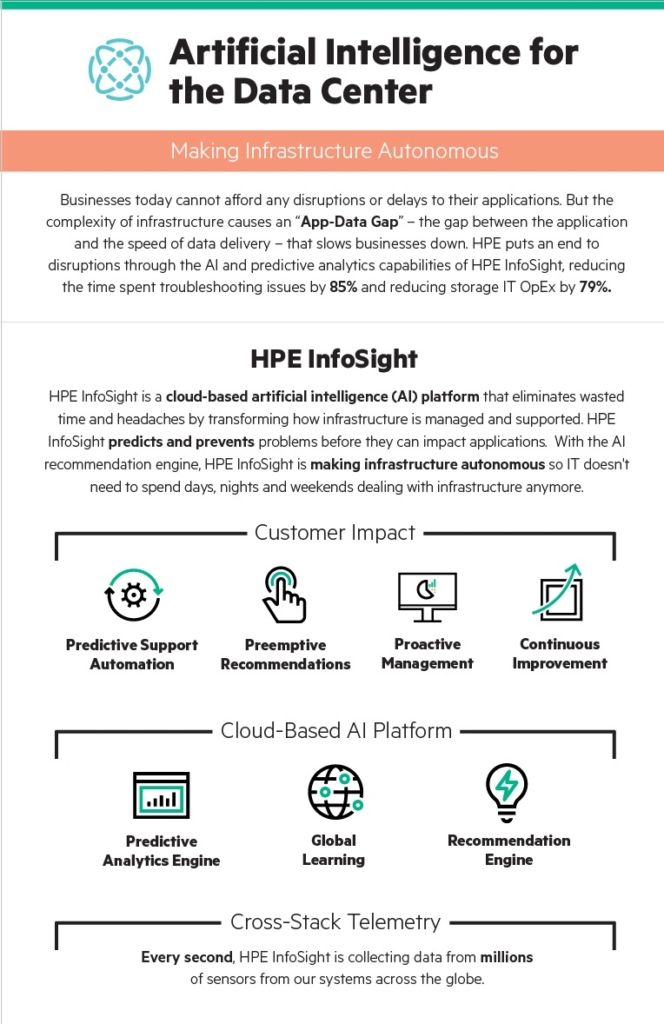

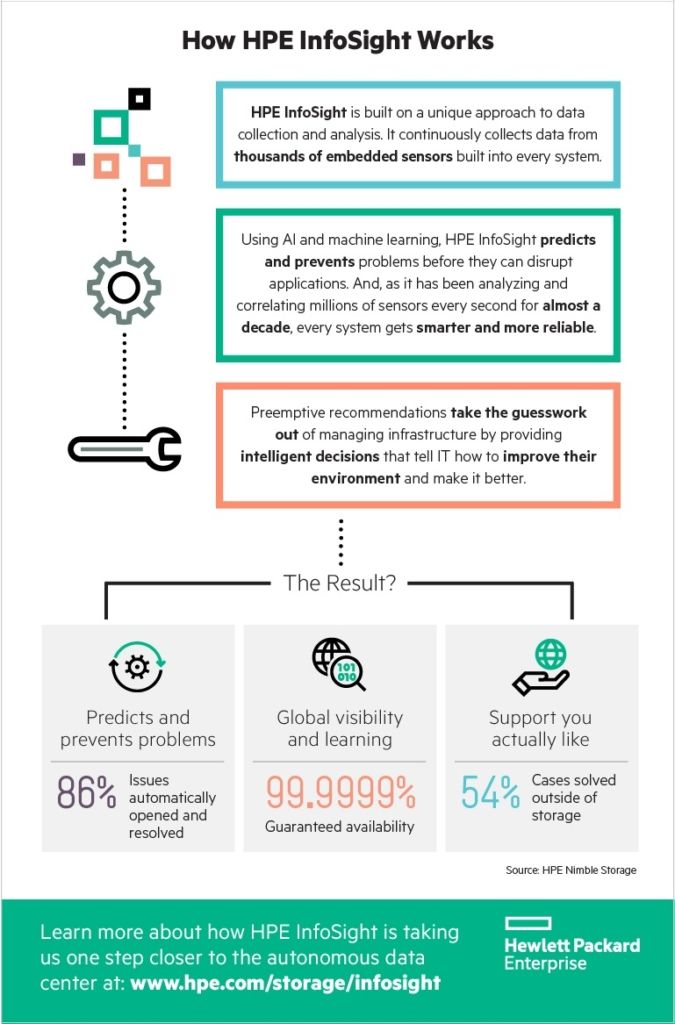

Il vero cuore pulsante delle soluzioni innovative presentate a Madrid è Hpe InfoSight, la cui nuova versione getta le basi verso il data center autonomo grazie a una forte accelerata sul versante dell’intelligenza artificiale. In particolare, Hpe ha introdotto il primo AI Recommendation Engine, un progetto volto a ridurre le problematiche di gestione delle infrastrutture e aumentare al contempo l’affidabilità delle applicazioni. L’obiettivo finale, come detto, è arrivare al datacenter autonomo, grazie a tecniche di machine learning avanzate.

Il dato di partenza è che in uno scenario competitivo sempre più data-driven anche per quanto riguarda le aziende “tradizionali”, nessuno può permettersi intoppi operativi o ritardi nelle applicazioni. Per questo motivo la nuova versione di InfoSight offre funzionalità di AI e analisi predittiva che, secondo dati Hpe, consente di ridurre fino all’85% il tempo dedicato a risolvere le problematiche. Per l’azienda grazie a queste soluzioni si può raggiungere il 99,9999% di disponibilità garantita e di continuità operativa.

Il funzionamento della nuova release di Hpe InfoSight è basato sull’AI Recommendation Engine, che consiglia preventivamente l’IT aziendale sulle azioni da intraprendere per evitare problemi, migliorare le prestazioni e ottimizzare le risorse disponibili. Le raccomandazioni sono basate, a loro volta, su oltre un decennio di dati raccolti e aggregati per dare vita a meccanismi avanzati di machine learning. Un sistema in continua evoluzione, che contribuisce a rendere i sistemi clienti più intelligenti e affidabili. Oltretutto, con una riduzione dei costi di storage del 79%. Il dato ancora più significativo è che negli ambienti HPE Nimble Storage, dove InfoSight offre le migliori prestazioni, si arriva a risolvere l’86% delle situazioni critiche prima ancora che il cliente possa accorgersi dell’insorgenza del problema.

L’intelligenza artificiale

InfoSight è solo uno dei progetti di AI su cui si sta concentrando Hpe. Nei mesi scorsi, infatti, l’azienda ha annunciato nuove piattaforme e nuovi servizi tailor made per le aziende che vogliono muoversi in questa direzione. La base di partenza è il deep learning, ovvero un sistema complesso che si ispira al cervello umano e che viene costantemente implementato per attività complesse quali il riconoscimento di volti, la classificazione di immagini e il riconoscimento vocale. Ma per sfruttare al meglio tutte le potenzialità, le aziende avrebbero bisogno di un’infrastruttura di calcolo che non solo potrebbe avere costi particolarmente elevati, ma che soprattutto è complicata da assemblare. Per venire incontro alle esigenze di implementazione del deep learning, Hpe ha messo a punto infrastrutture hardware e software su misura che si articolano in quattro proposte.

Hpe Rapid Software Development for AI

É una soluzione integrata HW-SW che consente il rapido sviluppo di applicazioni di deep learning, grazie a framework software preconfigurati per il deep learning.

Hpe Deep Learning Cookbook

É un set di strumenti che guidano il cliente nella scelta del migliore ambiente hardware e software in cui sviluppare le attività di deep learning. Questi tool consentono di stimare le performance delle varie piattaforme hardware. Inoltre, il Cookbook può essere utilizzato per convalidare performance e ottimizzare la configurazione di prodotti già acquistati.

Hpe AI Innovation Center

Sono centri per l’innovazione che agiscono da piattaforma per la collaborazione sulla ricerca tra università, aziende operanti all’avanguardia nella ricerca sulla AI e ricercatori Hpe.

Hpe Center of Excellence

Infine, il potenziamento dei centri studiati per assistere i dipartimenti IT e data scientist che intendono accelerare le proprie applicazioni di deep learning, massimizzando gli investimenti prodotti.

Hybrid IT

Come detto, Hpe ha da tempo deciso di puntare sull’HybridIT, una scelta rivendicata con forza da Stefano Venturi, che sostiene con forza la scelta fatta dalla azienda: «Siamo stati gli unici a difendere l’ideale del cloud ibrido come più aderente ai bisogni reali delle aziende. Ora captiamo dai clienti il bisogno di lavorare con diverse tipologie di cloud e più provider». La flessibilita’ del cloud con la sicurezza della localizzazione del dato o premise viene garantita tramite soluzioni di Flexible Capacity. Hpe può installare tutta la capacità richiesta – anche per i momenti di picco – nei data center del cliente, facendo pagare solo a consumo.

In un’ottica che si rivolge al manifatturiero, la digitalizzazione dei processi di produzione nelle fabbriche e negli impianti produttivi crea numerosi vantaggi, ma le applicazioni tradizionali sono spesso complesse e difficili da modernizzare. Per questo, Hpe ha elaborato soluzioni che consentano di semplificare l’installazione delle app presenti nel catalogo Cloud28+ – il più grande e completo aggregatore di cloud al mondo – riducendola a un processo di soli sei “click”.

Il futuro a breve termine è quello di una mole di dati sempre più significativa. Secondo quanto ci ha spiegato Mauro Colombo, country presales manager di Hpe, «il 70% dei dati viene generato sull’edge, cioè in periferia, dai sensori e dagli esseri umani. Nel 2020 si parlerà di dati di dimensioni enormi, si parla di “brontobyte”. Questi giganti non potranno essere portati al centro per l’elaborazione, nemmeno con le nuove reti 5G. Per questo crediamo che l’Intelligent Edge sia il futuro, che abbiamo deciso di legare a doppio filo con l’acquisizione di Aruba Networks, avvenuto due anni fa, leader in ambito wired e wireless, che ha portato a un’estensione dell’offerta di mobile engagement, digital workplace e perfino IoT». Per affrontare la progressiva espansione della quantità di dati in circolazione, Hpe ha messo a punto Superdome Flex, una nuova piattaforma di in-memory computing, scalabile e modulare, che può creare architettura flessibile con memoria scalabile da 6 TB a 48 TB.

Il Sistema Apollo 2000 Gen10

Nelle scorse settimane, Hpe ha annunciato il lancio di nuove soluzioni di archiviazione e di calcolo ad alta densità per consentire alle aziende di sfruttare appieno le applicazioni di HPC (High Performance Computing) e di AI. Queste nuove soluzioni sono racchiuse all’interno della piattaforma Hpe Apollo ( nella foto d’apertura articolo ). Le quattro proposte di HPE sono il Sistema Apollo 2000 Gen10, una piattaforma multiserver di nuova generazione che consente ai clienti di utilizzare applicazioni HPC e di deep learning anche se con spazio limitato all’interno del data center. La peculiarità di questa piattaforma, infatti, è l’elevata scalabilità. Apollo 70 è anch’essa una piattaforma scalabile che offre ancora maggiore scelta e flessibilità garantendo, tramite il suo processore a 64 bit, un workload a consumo intensivo di memoria che mette a disposizione fino al 33% di memoria in più rispetto ai server attuali.

Il Sistema Apollo 4510 Gen10 è la piattaforma che fa al caso dei clienti che vogliono ottimizzare la conservazione e il collocamento di enormi quantità di dati avvalendosi dello storage a oggetti come archivio attivo per l’accesso immediato ai dati strutturati e non. Infine LTO-8 Tape certifica il ritorno del nastro come ulteriore layer di protezione contro il cybercrimine e gli attacchi ransomware. Con questa soluzione di Hpe è possibile alleggerire lo storage primario a favore del nastro che garantisce una riduzione dei costi per il mantenimento dei dati nel tempo. Ogni cartuccia può arrivare a contenere fino a 30 terabyte, raddoppiando la capacità di archiviazione rispetto alla generazione precedente, la LTO-7.

La sicurezza

Con la presentazione della famiglia di server standard ProLiant Gen10, HPE ha messo a punto un sistema che riduce il costo per la virtual machine e che, al contempo, garantisce soluzioni per la sicurezza sempre più all’avanguardia. Due sono, in particolare, gli accorgimenti che consentono a questa virtual machine di avere i più elevati standard di sicurezza: la possibilità di crittografare integralmente o parzialmente la memoria per proteggere i dati da attacchi e altri tentativi di intrusione e la separazione delle chiavi crittografiche nelle aree condivise del sistema centrale.

Le partnership: da Eni ad Abb

Molte le partnership attivate da Hpe, da Microsoft a SAP passando per l’italiana Elmec. Sono due in particolare da segnalare: quella, recentissima, con Eni, e quella con Abb. La collaborazione tra Hpe e Eni ha l’obbiettivo di l’ implementazione del supercomputer commerciale più potente del mondo, in grado di raggiungere un picco di prestazioni pari a 18,6 Petaflop. Il nuovo supercomputer supporterà Eni nel processo di trasformazione digitale attraverso l’intera catena del valore – dalla fase di esplorazione e sviluppo dei giacimenti di petrolio e gas, alla gestione dei big data generati da tutti i beni produttivi. Denominato HPC4, è in grado di quadruplicare la potenza dell’intera infrastruttura già esistente rendendola la più potente al mondo a livello industriale e, associata a quella del sistema di supercalcolo già operativo (HPC3), la porterà a raggiungere una disponibilità di potenza di picco pari 22,4 Petaflop, vale a dire 22,4 milioni di miliardi di operazioni matematiche svolte in un secondo. Installato presso il Green Data Center di Eni di Ferrera Erbognone il sistema ospita l’intero ecosistema di algoritmi sviluppati internamente dall’ Eni (per maggiori dettagli vedi qui).

A riguardo l’Amministratore delegato di Eni, Claudio Descalzi, ha commentato: «Gli investimenti dedicati al potenziamento delle infrastrutture di supercalcolo e allo sviluppo di algoritmi rappresentano una parte importante del processo di trasformazione digitale di Eni. Per la nostra industria è sempre più vitale poter elaborare una quantità di dati in continua crescita, garantendo risultati sempre più accurati e in tempi rapidi: con HPC4 stiamo tracciando la strada dell’utilizzo di supercalcolatori di potenza exascale nel mondo dell’energia, sistemi che potrebbero rivoluzionare le modalità di gestione delle attività oil&gas. In linea con il nostro impegno per la sostenibilità, HPC4 è stato sviluppato in modo da ottenere il massimo livello di efficienza energetica. Inoltre, lo stesso Green Data Center che già utilizza tecnologie innovative per ridurre al minimo le emissioni di CO2 e i costi operativi».

L’architettura del nuovo supercalcolatore HPC4 è stata concepita con la stessa filosofia delle precedenti, tutte basate su una tecnologia cluster ibrida. HPC4 è costituito da 1.600 nodi Hpe ProLiant DL380, ognuno costituito da 2 processori Intel 24-core Skylake (per un totale di oltre 76,000 cores) e 2 acceleratori GPU NVIDIA Tesla P100. I nodi sono connessi attraverso una rete ad alta velocità EDR Infiniband. Il sistema HPC4 sarà affiancato da un sistema di archiviazione di 15 Petabytes ad alte prestazioni.

Passiamo ora, dopo averne data notizia qui, alla collaborazione con Abb, il cui obbiettivo è portare intelligenza all’interno degli impianti industriali, basandosi sulle soluzioni di hybrid IT di Hpe. In questo modo le aziende potranno avere a disposizione soluzioni in grado di generare insight pratici da un’enorme quantità di dati industriali, allo scopo di aumentare l’efficienza e la flessibilità delle operazioni.

Secondo quanto affermato dalla società di ricerche IDC, la spesa mondiale in IoT arriverà nel 2021 a 1,4 trilioni di dollari, mentre per il 2017 ci si attestava a 800 miliardi; gli investimenti più significativi interesseranno aree come produzione industriale, trasporti e utility. Le soluzioni messe a punto da Abb e Hpe vanno proprio in questa direzione, cercando di far funzionare i processi di acquisizione dati, analisi e controllo nelle vicinanze delle apparecchiature industriali per evitare problemi di latenza, sicurezza e affidabilità tipici dei sistemi IT remoti.

La partnership tra le due aziende consentirà di ricavare insight approfonditi e azioni automatiche dai dati industriali, accelerando l’elaborazione di enormi quantità di dati; gestire e controllare i processi industriali attraverso la supply chain, facendo leva sull’hybrid IT per permettere l’accesso ai dati critici a qualsiasi livello, dall’edge al cloud fino al core. Inoltre, nell’ottica di uno sviluppo dei data center, Abb e Hpe hanno messo a punto due soluzioni: una di automazione, che consente ai sistemi di alimentazione degli edifici dei data center di adattarsi automaticamente a incidenti o variazioni delle esigenze IT; la seconda consente un’ottimizzazione dei processi ed è elaborata appositamente per portare una capacità IT di livello enterprise nel punto di raccolta dati e controllo macchina.

Il futuro

Dopo il Discover di Madrid, Hpe ha mostrato una volta di più di non credere nelle soluzioni che vanno in un’unica direzione. L’ibridazione delle tecnologie di cloud e il riposizionamento del dato al centro del progetto delle aziende sono un passaggio fondamentale, in un momento in cui le aziende affrontano un’epocale digital transformation che, sempre secondo dati IDC, raggiungerà i 1.300 miliardi investiti soltanto nel 2018. Inoltre, entro il 2019 il 60% dei CIO ha in programma di completare il re-platforming – ovvero il processo di modernizzazione delle piattaforme esistenti – in modo che possano girare in ambienti cloud e mobili, preservando le loro funzionalità. A riprova che “the best is yet to come” e che la direzione presa da HPE sembra quella più sostenibile anche in ottica futura.