di Stefano Casini ♦ Viaggio tra gli algoritmi e le CPU del calcolatore industriale da 22,4 milioni di miliardi di operazioni matematiche al secondo, realizzato in collaborazione con HPE. A cosa serve, come funziona, come risparmia energia ma soprattutto come garantirà vantaggi competitivi e valore aggiunto alle strategie del cane a sei zampe

In un articolo pubblicato alla fine dello scorso anno, ci chiedevamo se il supercomputer sarebbe stato lo strumento per dominare il mondo della produzione nel prossimo futuro (vedi qui). Ed è un dato di fatto che la disponibilità di una ingente potenza di calcolo può dare un vantaggio decisivo nella gestione di big data strategici ai fini del processo di trasformazione digitale attraverso l’intera catena del valore. Lo sa bene Eni, che ha segnato una tappa fondamentale nel suo percorso di trasformazione digitale con la messa in opera, all’ inizio dell’anno, dell’elaboratore più potente al mondo in ambito industriale. Un primato che pone l’ azienda italiana all’avanguardia nel campo dell’High Performance Computing (Hpc), non solo nel settore energetico ma in assoluto tra tutte le aziende mondiali. Industria Italiana, attraverso l’analisi di un esperto Hi-Tech del colosso energetico nazionale, Marco Bianchi, Hpc Knowledge Owner dell’Eni, può raccontarvi nel dettaglio il percorso che ha portato a questo risultato. In una classifica assouta HPC4, il “super cervello elettronico” di ENI è tra i primi 12 super computer al mondo, compresi quelli a disposizione dei governi di Cina, Stati Uniti e Giappone. Realizzato con tecnologie Hewlett Packard Enterprise (HPE), il sistema di supercalcolo HPC4 è stato voluto e implementato dall’ENI per elaborare enormi quantità di dati.

High Performance Computing (Hpc): le ragioni di una scelta

Il gigante energetico del Belpaese punta sull’High Performance Computing (Hpc) perchè in certi ambiti i sistemi di calcolo ed elaborazione più sviluppati sono in grado di offrire un vantaggio competitivo rilevante rispetto alla concorrenza e a tecnologie meno potenti. Non solo: Eni punta sempre più su sistemi basati su una tecnologia Cluster ibrida, perché per una multinazionale dell’energia come quella del “cane a sei zampe” in molti casi è ritenuta più funzionale e vantaggiosa rispetto ad altre soluzioni. Il super calcolatore HPC4 è operativo dal febbraio scorso, presso il Green Data Center di Ferrera Erbognone, in provincia di Pavia, il Centro Hi-Tech sviluppato come un’unica infrastruttura IT che ospita tutta l’architettura Hpc e tutte le altre soluzioni gestionali del Gruppo energetico, con i sistemi informatici centrali di elaborazione, l’informatica gestionale e le applicazioni Oil & Gas. Il sistema di super calcolo quadruplica la potenza computazionale dell’intera infrastruttura del Green Data Center, rendendola la più potente al mondo a livello industriale e aziendale. Tutto ciò migliora ulteriormente la capacità dell’Eni di accelerare il time-to-market dei propri progetti, e di ottimizzare le strategie di gestione delle proprie risorse per tutti gli asset produttivi.

Uno step importante in un strategia di lungo periodo

L’Eni si trova in una fase cruciale del percorso strategico di digitalizzazione, che vede 150 progetti trasversali a tutte le aree di business e oltre 150 manager coinvolti, impegnati a raggiungere l’obiettivo di conseguire importanti benefici economici e operativi nel breve e medio termine. La società ha intrapreso la via della trasformazione digitale da diversi decenni, ed è riuscita nel tempo a trasformare la necessità di elaborare grandi quantità di dati in un grande vantaggio competitivo. Ora l’arrivo di HPC4, secondo l’ amministratore delegato Claudio Descalzi, rappresenta un passo importante nel processo di digitalizzazione dell’azienda ,visto che« per la nostra industria è sempre più vitale poter elaborare una quantità di dati in continua crescita, garantendo risultati sempre più accurati e in tempi rapidi. Con HPC4 stiamo tracciando la strada dell’utilizzo di supercalcolatori di potenza exascale nel mondo dell’energia, sistemi che potrebbero rivoluzionare le modalità di gestione delle attività Oil & Gas. In linea con il nostro impegno per la sostenibilità, HPC4 è stato sviluppato in modo da ottenere il massimo livello di efficienza energetica».

Per cosa viene utilizzato il supercomputer

Il super computer permette un’altissima capacità di elaborazione e stoccaggio dei dati, e viene usato principalmente per lo studio dei numeri provenienti dall’analisi del sottosuolo. Un aspetto fondamentale per le attività del Gruppo. Lo scopo principale è di «erogare la massima potenza per quegli algoritmi che servono alle nostre linee di business, per avere quei vantaggi competitivi che hanno contraddistinto il nostro Gruppo negli ultimi anni a livello mondiale» rileva Bianchi, l’esperto di High Performance Computing dell’Eni. Su HPC4 girano infatti i più evoluti programmi di calcolo: dati geofisici e delle prospezioni sismiche che Eni produce in tutto il mondo entrano nel Green Data Center, e vengono elaborati con modelli matematici che permettono di produrre una conoscenza accurata del sottosuolo. Tutti questi Big Data vengono elaborati con modelli matematici molto complessi, che permettono di “vedere” i giacimenti di petrolio e gas nascosti fino a 10 o 15 chilometri di profondità sotto la superficie terrestre, e distribuiti su aree di migliaia di chilometri quadrati.

«L’esplorazione e l’analisi del sottosuolo hanno l’obiettivo di ricostruire la struttura, e la “mappa”, delle aree su cui lavoriamo» spiega Bianchi, «in modo da individuare quelle configurazioni che potrebbero contenere concentrazioni di materie prime allo stato gassoso o liquido, petrolio o gas naturali, da sfruttare per il settore dell’energia. Per esplorare e analizzare la natura del terreno» spiega lo specialista Hi-Tech, «viene rilasciata una piccola quantità di energia che si diffonde nel sottosuolo. Queste onde energetiche si rinfrangono in presenza di determinati fattori e condizioni, e vengono intercettate da speciali sensori, i “Geofoni”. In questo modo, catturiamo tutti i dati, realizzando una sorta di “immagine” grafica del sottosuolo, attraverso i nostri strumenti di High Performance Computing».

Il ruolo di HPE

Tecnologie molto potenti e sofisticate fornite all’Eni da Hewlett Packard Enterprise, che «proprio nel campo dell’High Performance Computing sta investendo una parte consistente delle strategie di sviluppo, e delle proposte al mercato aziendale» rimarca Stefano Venturi, presidente e amministratore delegato di HPE Italia: «noi sviluppiamo, a livello mondiale, le tecnologie e piattaforme più evolute e performanti, per poi collaborare, a livello locale, con le realtà più innovative che fanno gli applicativi da utilizzare, in base alle esigenze specifiche dell’utente finale».

Con Hewlett Packard Enterprise «in meno di quattro mesi di calendario, da novembre 2017 a febbraio 2018, per la precisione in 57 giorni lavorativi totali, il super computer HPC4, un colosso Hi-Tech da 52 tonnellate, è stato installato e reso operativo» ha ricordato, con soddisfazione, Marco Bianchi, intervenendo all’HPE Italian Summit 2018, l’evento di due giorni che si è svolto nelle scorse settimane a Milano, nel corso del quale Hewlett Packard Enterprise ha incontrato partner e aziende clienti, come appunto Eni: «il cablaggio necessario, per stringere e ridurre i tempi al minimo, è stato effettuato addirittura a cavallo della pausa natalizia. Poi, nelle settimane successive, è stata fatta la configurazione del software e la messa in funzione della “macchina”. Tutto in appena 57 giorni, e per un lavoro del genere, è un risultato rilevante, tutt’altro che scontato».

I primi rilevanti risultati

Con l’HPC4, a maggio Eni ha stabilito il record mondiale nella modellazione numerica dei giacimenti Oil & Gas: in un tempo record di 15 ore il supercomputer ha eseguito 100mila simulazioni di modelli di giacimento ad alta risoluzione, tenendo conto delle variabili e delle incertezze geologiche. In confronto, la maggior parte degli ingegneri di giacimento possono eseguire in alcune ore solo una singola simulazione, con sistemi hardware e software basati solo su CPU. «I programmi di calcolo sviluppati dal super computer» spiegano gli ingegneri IT dell’Eni, «combinano gli algoritmi di Imaging sismico più accurato con le più moderne tecniche di programmazione. Per la quantità di dati, per la dimensione delle immagini che vogliamo ottenere, e per la complessità dei modelli matematici che usiamo per trasformare i dati in immagini, non è possibile utilizzare i normali computer, ma servono architetture di calcolo dedicate, la cui potenza corrisponde a quella di migliaia di computer comuni».

La performance di calcolo è stata ottenuta utilizzando la piena capacità del nuovo Cluster ibrido Hpc, dotato di 3.200 unità di elaborazione grafica GPU, e il software di simulazione di giacimento Echelon della Stone Ridge Technology. Sono state simulate «100mila differenti realizzazioni geologiche di un modello di giacimento ad alta risoluzione, costituito da 5,7 milioni di celle attive» spiega ancora Bianchi «ciascuna simulazione è stata eseguita su una singola GPU, in un tempo medio di 28 minuti per simulare 15 anni di produzione». Il percorso tracciato da questa tecnologia è parte integrante della strategia e della trasformazione digitale di Eni. Questa elaborazione non è solo una dimostrazione di potenza di calcolo, ma è anche il primo passo concreto per consentire a tutti gli ingegneri di giacimento dell’Eni di accedere a un potente strumento di elaborazione. In questo modo si potrà quantificare con più precisione l’incertezza geologica di ogni luogo e situazione, incorporare i dati acquisiti, aggiornando in maniera continuativa i modelli di giacimento degli asset produttivi.

Il Green Data Center di Eni

In uno scenario di Big data infiniti e complessi da trattare, va considerato che un Data Center moderno rappresenta principalmente una sfida non solo in termini di spazi utilizzati, ma soprattutto in termini di energia. Per dimensioni, concentrazione, trasporto, smaltimento termico ed efficienza complessiva, un Data Center presenta alcuni tra i problemi più complessi di gestione energetica. Inoltre l’IT è un settore di forte consumo energetico con fenomeni di inefficienza: ad esempio, in un Data Center di tipo ordinario, fino a due terzi dell’energia totale fornita in alimentazione viene utilizzata per alimentare i sistemi di Facility richiesti per garantire il funzionamento degli apparati informatici. Si tratta cioè dei sistemi per lo smaltimento del calore e per la gestione della continuità di esercizio, strumenti spesso di concezione antiquata, obsoleti e inadatti: gli spazi di miglioramento risultano quindi molto ampi.

Ma il Gruppo del “cane a sei zampe” non si limita a produrre energia: si impegna anche a non sprecarla. Per questo il Green Data Center è stato costruito attorno ai computer e, con innovazioni tecnologiche e architettoniche, riesce a consumare pochissima energia per il condizionamento dei sistemi di calcolo: il consumo elettrico dell’intero centro è poco più alto di quello richiesto dal funzionamento dei soli computer che lo compongono.

Il Green Data Center di Eni, inaugurato nel 2013, è stato sviluppato con l’obiettivo di garantire altissima affidabilità per tutte le esigenze informatiche aziendali, e nel contempo garantire i migliori risultati di efficienza energetica “Green”. Perché, per un colosso globale dell’energia come Eni, la grande “macchina” gestionale, organizzativa e produttiva non può permettersi cali di rendimento ed efficienza. L’impianto ospita tutti i sistemi centrali di elaborazione, destinati sia all’informatica gestionale che alle elaborazioni di simulazione computazionale di High Performance Computing. In totale oltre 7mila sistemi, con più di 60mila core CPU. L’impianto è progettato per poter ospitare sistemi IT con assorbimenti energetici fino a 30 MW di potenza IT utile, in uno spazio fino a 5.200 metri quadri. In questo modo, i supercalcolatori del Green Data Center (l’HPC3 e il nuovo HPC4) forniscono un supporto strategico al processo di trasformazione digitale di Eni lungo tutta la sua catena del valore, dalle fasi di esplorazione e sviluppo dei giacimenti di petrolio e gas, alla gestione dei Big data generati in fase operativa da tutti gli Asset produttivi.

«Le grandi necessità di calcolo e di elaborazione dati, ci hanno portato a cercare soluzioni efficienti dal punto di vista energetico e dei costi complessivi» sottolinea Bianchi, «e quindi già da tempo abbiamo iniziato a guardare all’Ibrido: nel 2013, in occasione dell’avvio del nuovo Data Center nelle campagne di Pavia, abbiamo cominciato a installare computer ibridi, tra cui appunto l’HPC4 di Hewlett Packard Enterprise. Il nostro prossimo rinnovo delle infrastrutture Hi-Tech è previsto nel biennio 2020-2021, e con ogni probabilità sarà basato ancora su piattaforme Linux e computer ibridi».

Un ecosistema di algoritmi di proprietà ENI

L’infrastruttura di calcolo di Eni funziona sulla base di un unico ecosistema di algoritmi molto complesso, creato e sviluppato nell’arco di oltre dieci anni e di proprietà di Eni, basato sull’esperienza e sul Know how della compagnia, che si è avvalsa anche della collaborazione di alcuni tra i più importati istituti di ricerca italiani.«Poter disporre di un programma creato e sviluppato internamente» fanno notare gli specialisti del “cane a sei zampe”, «significa pieno potere di controllo, flessibilità, velocità e continuo sviluppo di competenze. In questo modo, i super calcolatori di Eni forniscono un supporto strategico al processo di trasformazione digitale della compagnia». HPC4, in particolare, consente l’esecuzione e l’evoluzione degli algoritmi dedicati all’imaging geofisico tridimensionale, alla modellizzazione dei sistemi petroliferi, e all’elaborazione di modelli sofisticati di simulazione di giacimento e di ottimizzazione degli impianti produttivi. «Queste tecnologie» rimarca l’esperto di High Performance Computing dell’Eni, «ci consentono da una lato di accelerare e rendere più efficiente e accurato l’intero processo upstream, riducendo i rischi nella fase esplorativa e guadagnando al contempo un notevole vantaggio tecnologico. Ma anche di aumentare il livello di affidabilità, integrità tecnica e continuità operativa di tutti i nostri impianti, con benefici sia in termini di sicurezza che di impatto ambientale».

L’architettura del nuovo super calcolatore HPC4

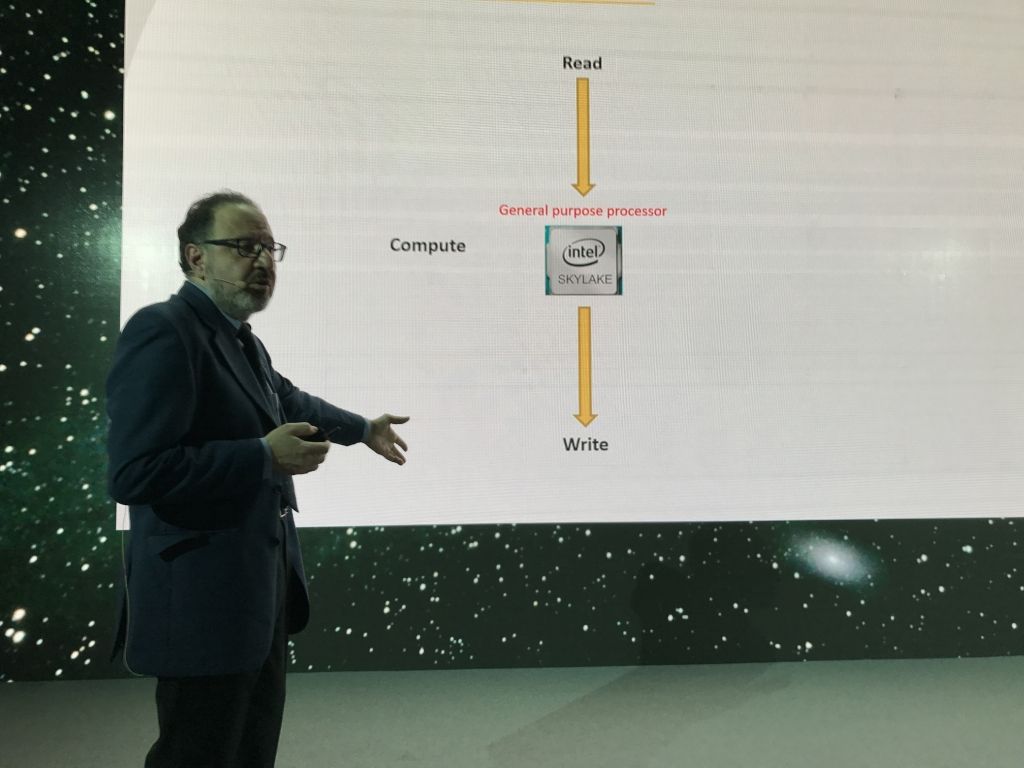

E’ stata concepita con la stessa filosofia delle precedenti, tutte basate su una tecnologia Cluster ibrida. «Nei sistemi tradizionali di calcolo ed elaborazione dati, il percorso è piuttosto semplice: leggo il dato, lo elaboro, scrivo il risultato. Indipendentemente da quanto il calcolo da effettuare sia complesso» sottolinea Bianchi: «nel caso dell’architettura ibrida, accanto al processore General Purpose processor, in grado di elaborare qualsiasi tipo di algoritmo, viene affiancato uno Special co-processor, un “acceleratore”, sul quale dirotto quelle parti e operazioni del calcolo che, per le loro caratteristiche, risultano particolarmente idonee per quel tipo di strumento. E anche dal punto di vista del modello di programmazione, quello ibrido non è un modello che va bene per tutti, quindi prima di adottare un sistema complesso di questo tipo, occorre fare un’analisi approfondita delle esigenze di calcolo reali, per verificare se “il gioco vale la candela”. Ma per esigenze di calcolo e di elaborazione come le nostre, uno dei vantaggi del modello ibrido è, ad esempio, che la GPU del sistema è costantemente più efficiente della CPU di un modello tradizionale».

[boxinizio]

I numeri di HPC4

Ecco i numeri di questo “mostro” tecnologico da record mondiale per un’azienda. HPC4 ha una performance di picco pari a 18,6 PetaFlop (“Floating point operations”, indica il numero di operazioni eseguite per secondo dalla CPU del sistema), che, associata a quella del sistema di supercalcolo già operativo in precedenza, ovvero l’HPC3, porta l’infrastruttura complessiva a raggiungere una disponibilità di potenza di picco pari a 22,4 PetaFlop al secondo. Vale a dire 22,4 milioni di miliardi di operazioni matematiche svolte in un secondo.

Tanto per dare l’idea, ai non addetti ai lavori: un PetaFlop è talmente enorme che, per elaborarlo, un computer deve svolgere un numero di calcoli pari a più del doppio delle stelle della via lattea. Oppure, se ognuno dei 7 miliardi e mezzo di abitanti della Terra avesse a sua disposizione un computer personale in grado di fare due milioni e mezzo di operazioni matematiche al secondo – ogni secondo, ogni giorno, ogni notte, domeniche e festivi inclusi –, tutti gli uomini del Pianeta sarebbero in grado di generare una potenza di calcolo paragonabile a quella di HPC4.

Il sistema fornito da Hewlett Packard Enterprise è costituito da 1.600 nodi HPE ProLiant DL380, ognuno formato da 2 processori Intel 24-core Skylake (per un totale di oltre 76mila Cores) e 2 acceleratori GPU Nvidia Tesla P100. I nodi sono connessi attraverso una rete ad alta velocità Edr Infiniband. «Se si prendono a riferimento i valori riportati nell’ultima classifica Top500 dei super computer più potenti al mondo, pubblicata nel novembre scorso, il sistema di super calcolo di Eni si colloca tra i primi dieci al mondo, primo assoluto tra i sistemi non-governativi e non-istituzionali.- precisa l’azienda -La prossima classifica mondiale verrà pubblicata tra poco, e prevediamo che il nostro super computer potrà classificarsi tra l’undicesimo e il dodicesimo posto in assoluto, perché ci sarà qualche New Entry di rilievo. Ma sarà sempre il primo in ambito industriale e aziendale».

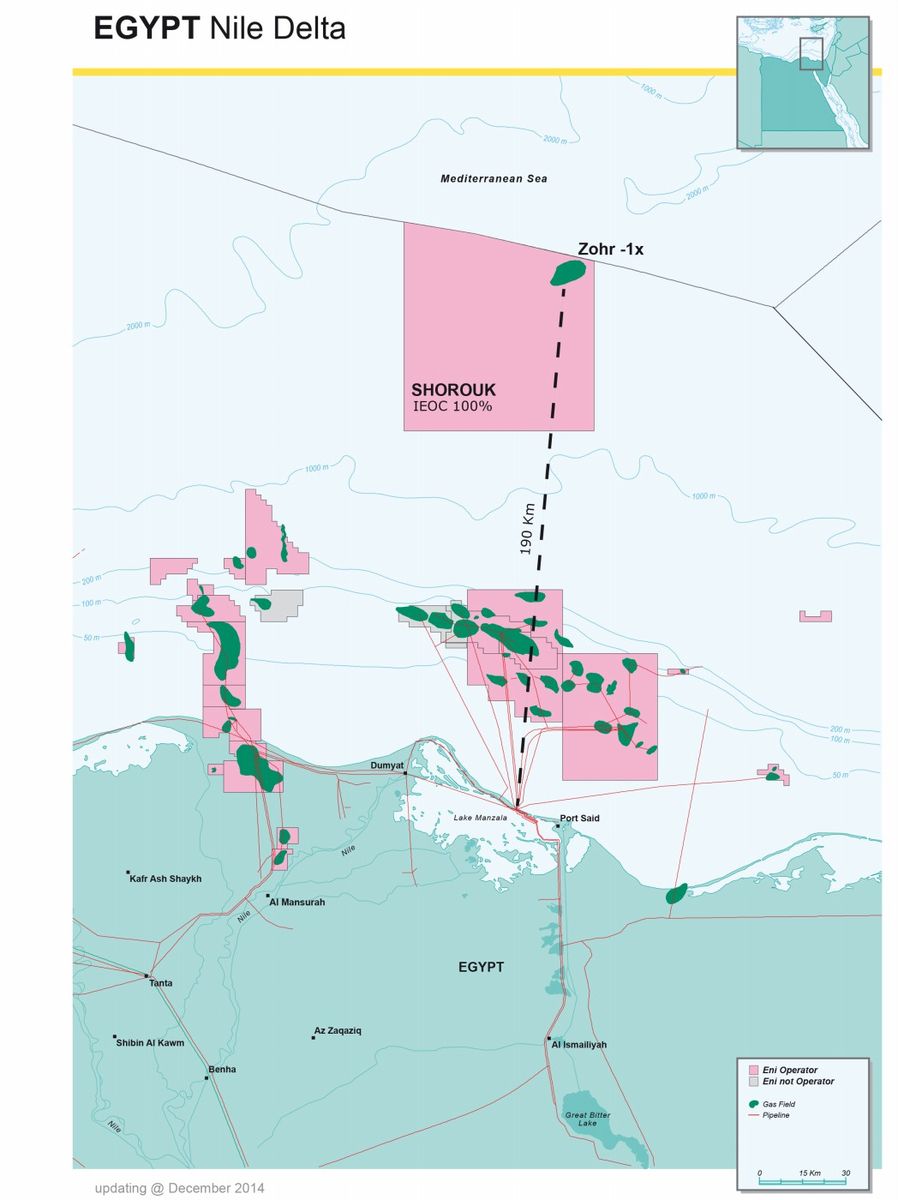

Uno strumento strategico per l’esplorazione

Con l’impiego e lo sviluppo di queste tecnologie Eni riesce a scovare idrocarburi dove tutte le altre compagnie neanche si immaginano di trovarne. Come nel giacimento off-shore egiziano di Zohr, solo per fare qualche esempio. I rilievi di Zohr contano un volume complessivo pari a 11mila chilometri cubi. Che significa questo? Vuol dire che l’ immagine sismica del giacimento, che i tecnici Eni devono analizzare in dettaglio, è composta da 717 milioni di pixel. Per visualizzarla servirebbero 87 televisori 4K. In un’ora HPC4 riesce a calcolare il 3% di questa immagine, mentre il suo predecessore HPC3 arrivava solo allo 0,5% del totale. Un altro esempio: HPC4 calcola l’intero risultato in un giorno e 6 ore, la versione HPC2 avrebbe richiesto almeno 8 giorni. Il vantaggio competitivo è anche questo.